監控全綠燈,使用者卻崩潰?故事開場很詭異

監控系統這種東西啊,唉,有時候看起來都沒事,實際上卻總有點不對勁——講了你也許不信,大概前陣子吧,某個客戶的網站就遇到一模一樣的狀況。那畫面我現在想還記得,嗯…工程團隊一臉快崩潰,氣氛很低落。不是什麼大企業啦,就是一般常見那種網路服務組合:Node.js負責後端、資料庫接在旁邊,全部流量都丟給nginx,再擺到雲端伺服器上頭。這結構其實沒多神秘,我猜應該超多公司都差不多這樣搭吧?突然想到,上次朋友聚會有人也是抱怨類似問題——欸,好像扯遠了。

話說回來,那次事情就是這麼開場的。本來大家想著哪裡出錯一定會被監控發現,可偏偏用戶一張張反映「頁面進不了」或者看到些莫名其妙的錯誤訊息,但那些指標、圖表居然還是綠色全亮,好像根本什麼都沒發生過。真的很煩人耶。其實現在回想起來,當時有些細節大家自己也搞糊塗,到底是哪個流程卡住?還是某個服務偶爾抽風?甚至有人懷疑是不是雲端平台本身突然小爆炸一下——唉,不知道是不是太敏感了。不過講真的,那陣子團隊討論不停轉圈圈。

你聽過類似經歷嗎?反正每次遇到怪問題,下意識第一步不是去翻各種數據、面板嘛。但這回真的是怎麼看都不像能一下抓出的毛病,你要說複雜,其實蠻單純的一套架構;碰到了卻只能硬著頭皮慢慢拆解找緣由。有意思的是,有些徵兆當下完全看不清楚,事後才猛然發現早就藏著線索,只是當下腦袋打結沒聯想到罷了。嗯,有時候人就是容易漏掉細微之處吧?

總之,用戶投訴持續了一陣子,團隊裡還有人開始懷疑是不是最近改設定改壞掉——也沒誰敢拍胸脯說查得乾淨明白,到底是哪裡出了岔子,大概只有親身熬過的人才懂那股無力又窘迫的心情。我自己每次遇到,都會忍不住問:「到底監控在幹嘛?」好啦,又離題了。

話說回來,那次事情就是這麼開場的。本來大家想著哪裡出錯一定會被監控發現,可偏偏用戶一張張反映「頁面進不了」或者看到些莫名其妙的錯誤訊息,但那些指標、圖表居然還是綠色全亮,好像根本什麼都沒發生過。真的很煩人耶。其實現在回想起來,當時有些細節大家自己也搞糊塗,到底是哪個流程卡住?還是某個服務偶爾抽風?甚至有人懷疑是不是雲端平台本身突然小爆炸一下——唉,不知道是不是太敏感了。不過講真的,那陣子團隊討論不停轉圈圈。

你聽過類似經歷嗎?反正每次遇到怪問題,下意識第一步不是去翻各種數據、面板嘛。但這回真的是怎麼看都不像能一下抓出的毛病,你要說複雜,其實蠻單純的一套架構;碰到了卻只能硬著頭皮慢慢拆解找緣由。有意思的是,有些徵兆當下完全看不清楚,事後才猛然發現早就藏著線索,只是當下腦袋打結沒聯想到罷了。嗯,有時候人就是容易漏掉細微之處吧?

總之,用戶投訴持續了一陣子,團隊裡還有人開始懷疑是不是最近改設定改壞掉——也沒誰敢拍胸脯說查得乾淨明白,到底是哪裡出了岔子,大概只有親身熬過的人才懂那股無力又窘迫的心情。我自己每次遇到,都會忍不住問:「到底監控在幹嘛?」好啦,又離題了。

大家都怪開發,數據其實一片祥和但哪裡不對勁

某段時間,唉,也不知道到底是不是宿命,反正就是會碰上那種「502 Bad Gateway」或者「503 Service Unavailable」的詭異畫面。這些頁面,其實乍看之下就像機器在偷懶時丟給人類的一張臭臉。講到這邊我突然想到上次買咖啡時店員也是一副愛理不理的樣子——啊,說遠了。我是想說,這種狀況真沒什麼規律,好像老天爺隨時抽號碼牌要你中獎。有時剛用還挺順,一眨眼又壞掉了。嗯,有人還特地寫信去罵支援信箱,那個收件匣都快炸開了,大夥兒其實都被弄得有點抓狂。

然後嘛——欸,每次出事第一個被噴的就是開發團隊。只要消息一傳出去,大概七八成的人下意識就覺得:「肯定是你們工程師寫壞東西吧?」連主管也差不多,都直接一句話:「去修應用程式啦。」運維那邊也是搖搖頭,「看起來像是哪裡寫錯囉」。顧問倒是不太激動,可語氣裡總藏著幾分微妙暗示:「或許該檢查一下軟體邏輯。」有時候想一想,其實責任鍋甩來甩去也挺滑稽的,不過、嗯……拉回來。

但說真的,開發人員其實一直盯著現場沒鬆懈。他們翻記錄、檢查流程,也順便瞄過系統資源那些——記憶體看起來還好;CPU 頂多用到三分之一不到;資料庫運行也算平穩。如果硬要挑個明顯漏洞,還真是找不到啥大破綻。至於那個監控工具(叫 Watchdog),每天把所有指標都秀得乾乾淨淨,看起來數據正常到不行,小波動幾乎察覺不到……結果偏偏有人遇到讓人心煩的失敗畫面。每次看到這種事,我都忍不住自問,是不是哪個幽靈在搞鬼?唉,好啦繼續。

所以問題到底在哪?目前好像誰都說不清楚。有些細節連大家自己也拿不太準,只能靠猜了吧,大概還得再等等才有答案。

然後嘛——欸,每次出事第一個被噴的就是開發團隊。只要消息一傳出去,大概七八成的人下意識就覺得:「肯定是你們工程師寫壞東西吧?」連主管也差不多,都直接一句話:「去修應用程式啦。」運維那邊也是搖搖頭,「看起來像是哪裡寫錯囉」。顧問倒是不太激動,可語氣裡總藏著幾分微妙暗示:「或許該檢查一下軟體邏輯。」有時候想一想,其實責任鍋甩來甩去也挺滑稽的,不過、嗯……拉回來。

但說真的,開發人員其實一直盯著現場沒鬆懈。他們翻記錄、檢查流程,也順便瞄過系統資源那些——記憶體看起來還好;CPU 頂多用到三分之一不到;資料庫運行也算平穩。如果硬要挑個明顯漏洞,還真是找不到啥大破綻。至於那個監控工具(叫 Watchdog),每天把所有指標都秀得乾乾淨淨,看起來數據正常到不行,小波動幾乎察覺不到……結果偏偏有人遇到讓人心煩的失敗畫面。每次看到這種事,我都忍不住自問,是不是哪個幽靈在搞鬼?唉,好啦繼續。

所以問題到底在哪?目前好像誰都說不清楚。有些細節連大家自己也拿不太準,只能靠猜了吧,大概還得再等等才有答案。

Comparison Table:

| 核心要點 | 內容摘要 |

|---|---|

| 監控頻率 | 確保CPU、記憶體等系統指標的檢查頻率至少在1分鐘內,網路流量變化建議每30秒左右檢查,應用程式回應速度則需在10秒以內。 |

| 資料趨勢分析 | 不僅關注當前狀態,也要考慮最近變化的速度及整體趨勢,以辨識潛在問題。 |

| 多層次觀察 | 從底層硬體到服務表現和使用者反饋,應該全面性地進行觀察,以便發現隱藏的小問題。 |

| 即時回報機制 | 鼓勵用戶主動反饋問題,不要忽視他們的聲音,這可能是發現系統漏洞的重要來源。 |

| 定期測試監控設置 | 定期檢查監控工具是否能準確捕捉實際存在的問題,避免對錯誤數據產生依賴。 |

看似沒事,其實有事:五分鐘一次的盲點

當時所有監控指標看起來都挺正常的欸,全部那堆數字乖乖地在安全範圍內閃爍,像是在跟人說「沒事啦別緊張」。但、嗯,好奇怪,就是有用戶還是會碰到錯誤訊息。唉,我朋友也請過人幫忙處理,通常嘛,第一步就是去盯那個儀表板。結果看半天——數據還真沒什麼異樣,甚至乾淨到讓人覺得有點太過刻意(怎麼會?)。我剛才還差點分心想查一下隔壁組的監控,不過算了先回來這裡。

其實這種狀況也不是多罕見啦。有段時間修系統修到麻木,後來慢慢體會出一點東西:那些監控圖表如果美得像教科書上的案例……唔,不一定代表真的沒問題,有時候反而更詭異。就像——啊對,上次搭計程車突然想到,如果你每小時才偷瞄一次引擎溫度,那種引擎偶發過熱、只持續幾分鐘又自動降溫的情形,你根本抓不到。每次檢查都很剛好錯開那些出包的瞬間,所以畫面上一切安然,可現實上差點翻車。

再拉回這件事好了。我重新梳理那五百多則錯誤訊息,其實沒完全亂七八糟,大致找得到一些規律。不是隨機爆炸,而是某些時段——用戶量稍微升高的片刻——特別容易冒出來。但又不是什麼驚人的流量尖峰,也沒有螢幕上紅色警報燈閃爍,就是那種偶爾人潮稍多,但數字又不夠明顯讓你一眼看穿。其實講到這邊我腦袋已經有點亂(大概晚飯吃太飽),但總之這類情形,只能靠反覆對照時間跟細節,一點一滴把端倪慢慢拼湊起來吧。

其實這種狀況也不是多罕見啦。有段時間修系統修到麻木,後來慢慢體會出一點東西:那些監控圖表如果美得像教科書上的案例……唔,不一定代表真的沒問題,有時候反而更詭異。就像——啊對,上次搭計程車突然想到,如果你每小時才偷瞄一次引擎溫度,那種引擎偶發過熱、只持續幾分鐘又自動降溫的情形,你根本抓不到。每次檢查都很剛好錯開那些出包的瞬間,所以畫面上一切安然,可現實上差點翻車。

再拉回這件事好了。我重新梳理那五百多則錯誤訊息,其實沒完全亂七八糟,大致找得到一些規律。不是隨機爆炸,而是某些時段——用戶量稍微升高的片刻——特別容易冒出來。但又不是什麼驚人的流量尖峰,也沒有螢幕上紅色警報燈閃爍,就是那種偶爾人潮稍多,但數字又不夠明顯讓你一眼看穿。其實講到這邊我腦袋已經有點亂(大概晚飯吃太飽),但總之這類情形,只能靠反覆對照時間跟細節,一點一滴把端倪慢慢拼湊起來吧。

高峰期?非也,小流量才是致命陷阱

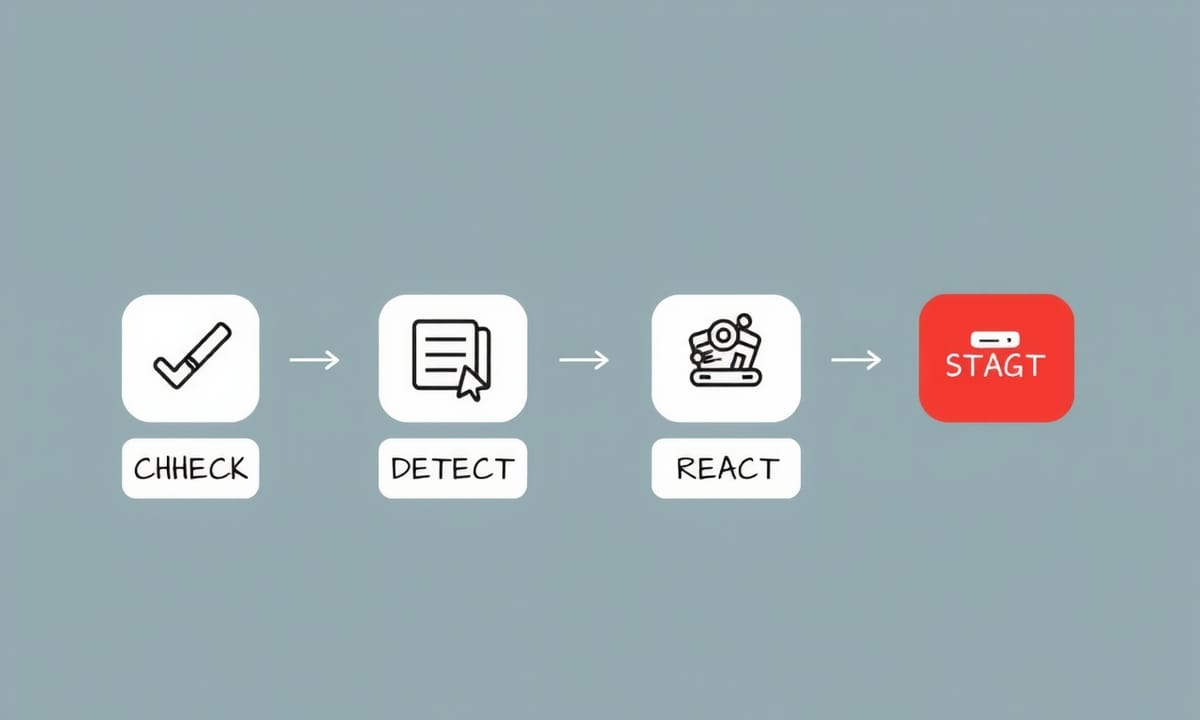

有一次,嗯,我突然發現他們那個叫Watchdog的監控機制,其實檢查伺服器的頻率很低。真的不是我在誇張,大概每隔五分鐘才會瞄一眼,像是在喝咖啡打盹,然後再勉強起身掃一下環境。唉,我一想到要是發生什麼事,這間隔也太長,好吧,總之如果時間拉得更久,它還會拖更久才巡一次——你能想像嗎?就像有人邀你看電影,但全片只讓你偷看開頭和結尾兩三張畫面,中間那些打鬥、高潮、甚至主角怎麼摔跤都沒給你看。我一度開始懷疑這到底算不算真的在監控,不過還是拉回來說正事。

後來,有個人就試著遊說他們換另一套東西,叫Prometheus。欸,這名字聽起來有點神話感,但其實它厲害的地方就是能把檢查頻率拉高到十幾秒就盯一次,不用像前面那樣等半天。有點像他直接講:「不如我開著看個幾小時,看看到底漏掉什麼。」結果咧,只跑了三四個小時,那癥結馬上浮出水面——根本不用等到天荒地老。

事情其實有點複雜啦,但簡單說,每當流量稍微多一點,伺服器裡可用記憶體就刷地被消耗光。我也不敢百分百肯定是不是只有這個原因,就是…數據看起來好像大部分問題都卡在那種短暫又突發的資源緊繃上。對了,我剛才差點忘記自己要講什麼(腦袋最近很亂),但反正,如果還維持原本那種五分鐘才掃一次,大概根本抓不到當下哪裡爆炸,也許更多細節都直接被忽略掉。不過,一換成高頻追蹤模式,你就會親眼看到記憶體瞬間見底的場景——真的是「一閃即逝」的小麻煩啊,有時候觀察密度決定你能不能逮住它們。嗯,就這樣吧。

後來,有個人就試著遊說他們換另一套東西,叫Prometheus。欸,這名字聽起來有點神話感,但其實它厲害的地方就是能把檢查頻率拉高到十幾秒就盯一次,不用像前面那樣等半天。有點像他直接講:「不如我開著看個幾小時,看看到底漏掉什麼。」結果咧,只跑了三四個小時,那癥結馬上浮出水面——根本不用等到天荒地老。

事情其實有點複雜啦,但簡單說,每當流量稍微多一點,伺服器裡可用記憶體就刷地被消耗光。我也不敢百分百肯定是不是只有這個原因,就是…數據看起來好像大部分問題都卡在那種短暫又突發的資源緊繃上。對了,我剛才差點忘記自己要講什麼(腦袋最近很亂),但反正,如果還維持原本那種五分鐘才掃一次,大概根本抓不到當下哪裡爆炸,也許更多細節都直接被忽略掉。不過,一換成高頻追蹤模式,你就會親眼看到記憶體瞬間見底的場景——真的是「一閃即逝」的小麻煩啊,有時候觀察密度決定你能不能逮住它們。嗯,就這樣吧。

Prometheus登場,每15秒的秘密揭曉

講到記憶體那點破事,其實我自己也常搞不懂到底怎麼回事。平時伺服器用量頂多四成,嗯,這數字大部分時間看起來都挺正常。可說也奇怪,偶爾它就像被什麼東西踩了一腳,突然飆到快滿載——那種瞬間暴衝的狀態,唉,我真的不知道該說什麼才好。有時你看著監控畫面還在發呆,欸結果一眨眼,大概一兩分鐘內吧,那台機器直接喘不過氣,新請求統統卡門外。其實我有時候會懷疑,是不是自己錯覺?但偏偏連續幾次都是這樣:不到三分鐘,一切又乖乖回穩,好像剛才啥都沒發生過。誒,我是不是太敏感?

然後那個古老監控系統每五分鐘掃一次資料,只能說真夠敷衍,它硬是把那些短命卻麻煩的高峰全漏掉啦。例如早上十點整,看一眼還是四成用量——誰會想到兩分鐘後會有災難?差不多十點零二分,那詭異高峰突如其來,用戶開始抱怨連不上(有人說類似五百多號錯誤碼),然後等到十點零五分再查,又是一片平靜,好像剛才只是幻覺。有時候真的想罵人啊。大家也就自然而然以為系統一直很健康,只是因為監控根本沒抓住那些尷尬瞬間。我是不是太在意細節了?

還有件事讓人摸不著頭腦,就是應用程式日誌完全沒出現任何錯誤訊息。一開始不少人猜是不是程式碼寫壞,可仔細想想,如果機器記憶體早就被擠爆,那些服務根本輪不到執行,更別提應用層級問題了。舉個例好了,就像你去一家超熱門餐廳,人都還沒進門口,就被告知客滿無法入場,自然沒機會抱怨菜色難吃咧。我突然想到上週也是這樣,被拒絕在外面曬太陽。

或許只是檢查頻率設得太鬆散,把掃描時間縮短,也許比較容易逮到問題,但唔……這只是一種可能啦,到底要怎麼解決,其實還要大家慢慢討論吧。我現在腦袋有點亂,不知道是不是咖啡喝太多了。

然後那個古老監控系統每五分鐘掃一次資料,只能說真夠敷衍,它硬是把那些短命卻麻煩的高峰全漏掉啦。例如早上十點整,看一眼還是四成用量——誰會想到兩分鐘後會有災難?差不多十點零二分,那詭異高峰突如其來,用戶開始抱怨連不上(有人說類似五百多號錯誤碼),然後等到十點零五分再查,又是一片平靜,好像剛才只是幻覺。有時候真的想罵人啊。大家也就自然而然以為系統一直很健康,只是因為監控根本沒抓住那些尷尬瞬間。我是不是太在意細節了?

還有件事讓人摸不著頭腦,就是應用程式日誌完全沒出現任何錯誤訊息。一開始不少人猜是不是程式碼寫壞,可仔細想想,如果機器記憶體早就被擠爆,那些服務根本輪不到執行,更別提應用層級問題了。舉個例好了,就像你去一家超熱門餐廳,人都還沒進門口,就被告知客滿無法入場,自然沒機會抱怨菜色難吃咧。我突然想到上週也是這樣,被拒絕在外面曬太陽。

或許只是檢查頻率設得太鬆散,把掃描時間縮短,也許比較容易逮到問題,但唔……這只是一種可能啦,到底要怎麼解決,其實還要大家慢慢討論吧。我現在腦袋有點亂,不知道是不是咖啡喝太多了。

記憶體突然爆炸,502錯誤瞬間來襲又消失

事情過了之後,說實話,也沒什麼驚天動地的新招數啦,大家這才慢慢摸清楚癥結是在哪裡。欸,我還記得當時我們搞了一個自動擴充的機制——就是那種伺服器一忙起來,自己就會多加幾台新機進來湊熱鬧的設計。其實這想法本身沒啥問題,可惜一開始設定觸發點訂得太晚,主機容量都快逼近八成才要反應,唉,到時候手忙腳亂也不是沒有道理。

講到這個,我忽然想到那時候有誰半夜還在群組抱怨,不過好像又扯遠了。拉回來說,所以後來只好提早點行動,大約七成多就讓系統趕緊補增新伺服器,而且還把檢測跟應對的速度調快一些,尤其是流量剛有徵兆升溫時能馬上處理,比之前靈敏不少。嗯,其實說不定還是會漏掉什麼,但總比原本那種「等著爆炸」強吧。

細節部分嘛,其實也未必百分百精確,那天晚上到底是幾個小時內解決完?還是拖到隔天早上才全部恢復?老實說,有人記憶都不太一樣。嗯,我也是聽別人轉述,大概不到一天吧,反正那些502錯誤訊息後來就再也沒出現了。欸,其實開發團隊剛開始被罵得挺慘,好像全天下都是他們害的,但仔細想想也挺冤枉——他們寫的程式碼基本上沒大漏洞,只能說觀察方法出了差池。

講著講著,又差點忘了重點,其實整件事根本不只是記憶體、主機數量或自動化那些參數在作祟,更像是在提醒,如果監控工具看不到問題癥結,你怎麼折騰都只是白費勁。有點類似蒙著眼修車吧,你只能聽聲音卻完全找不到是哪顆螺絲在鬧鬼。有些監控系統盲區真的是很隱晦,有時候你根本無從察覺。我們遇到狀況時,也不是每次都能立刻抓出缺口在哪,只能說這次算運氣好,有驚無險混過去了,好吧,就這樣。

講到這個,我忽然想到那時候有誰半夜還在群組抱怨,不過好像又扯遠了。拉回來說,所以後來只好提早點行動,大約七成多就讓系統趕緊補增新伺服器,而且還把檢測跟應對的速度調快一些,尤其是流量剛有徵兆升溫時能馬上處理,比之前靈敏不少。嗯,其實說不定還是會漏掉什麼,但總比原本那種「等著爆炸」強吧。

細節部分嘛,其實也未必百分百精確,那天晚上到底是幾個小時內解決完?還是拖到隔天早上才全部恢復?老實說,有人記憶都不太一樣。嗯,我也是聽別人轉述,大概不到一天吧,反正那些502錯誤訊息後來就再也沒出現了。欸,其實開發團隊剛開始被罵得挺慘,好像全天下都是他們害的,但仔細想想也挺冤枉——他們寫的程式碼基本上沒大漏洞,只能說觀察方法出了差池。

講著講著,又差點忘了重點,其實整件事根本不只是記憶體、主機數量或自動化那些參數在作祟,更像是在提醒,如果監控工具看不到問題癥結,你怎麼折騰都只是白費勁。有點類似蒙著眼修車吧,你只能聽聲音卻完全找不到是哪顆螺絲在鬧鬼。有些監控系統盲區真的是很隱晦,有時候你根本無從察覺。我們遇到狀況時,也不是每次都能立刻抓出缺口在哪,只能說這次算運氣好,有驚無險混過去了,好吧,就這樣。

應用程式日誌乾淨如新門外排隊吃閉門羹

有時候啊,大家為了省點空間、順便壓低預算,監控的檢查頻率就會被調得很低。嗯,這種感覺像是在拍電影,但只截取一些精華片段給你看——說真的,乍看只是細緻度不同,可是實際運作時,很多讓人頭疼的小毛病,其實就這樣被遺漏掉了。唉,我常想,到底誰會願意只靠幾分鐘才瞄一次的監控?可是現實裡還是有不少人這麼做。

其實這狀況挺普遍的啦。欸,有時寫到這邊突然想起以前那種伺服器又大又慢,那個時代什麼都拖很久,所以大家對監控也沒太多要求,反正出問題處理速度慢到天荒地老。但現在咧?應用服務動不動一分鐘內就恢復正常,可工具還活在過去,好像時間沒前進一樣。有點無奈。

現代系統自己會自動伸縮嘛,有些波動快得像眨眼一樣,一下子問題發生,一下子又修好。如果你的監控還卡在十年前的步調,那缺漏的細節大概比你想像得多吧。嗯……講著講著忽然想到昨天看到某篇文章也是這樣,不過扯遠了,拉回來——重點就是別偷懶。

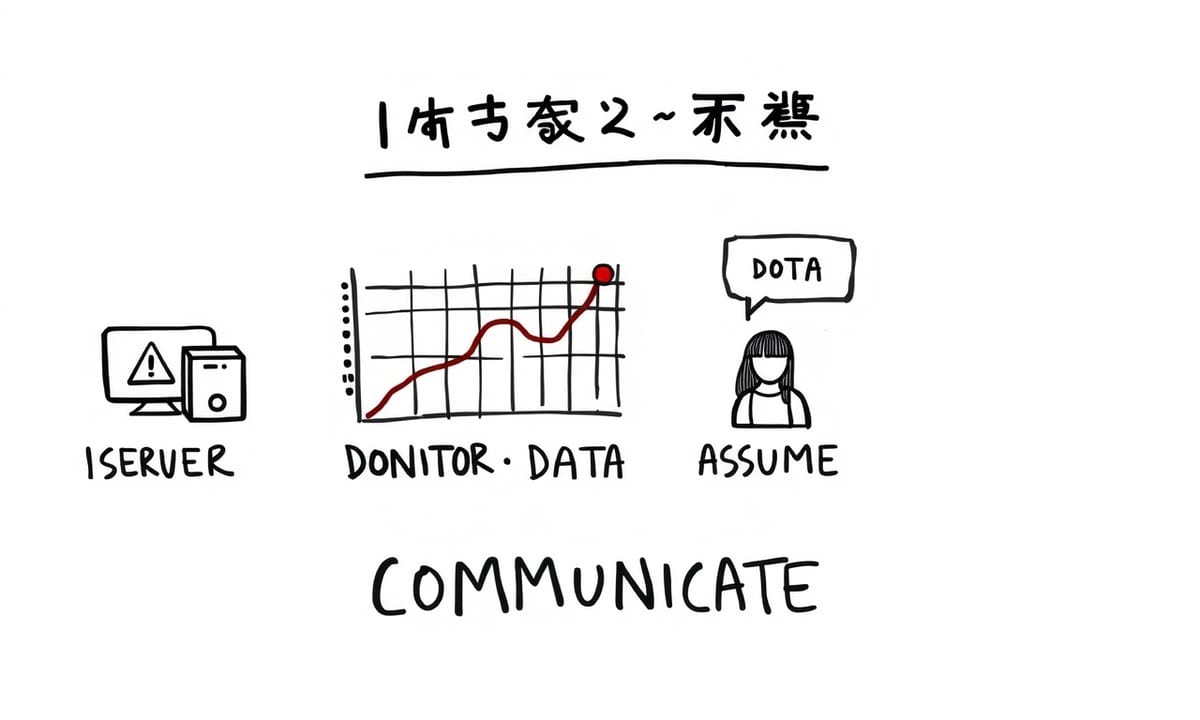

如果你看到這裡突然心裡一震,「欸,好像我家情況差不多?」其實也不用太緊張,可以自己簡單檢查一下。例如你家的監控到底多久才掃描一次CPU或記憶體?據說一般能忍受的極限,大概是一分鐘內要掃一次;網路流量變化勤快點,大致半分鐘上下比較保險;至於應用程式回應速度,有些人甚至堅持十多秒就該盯一回;錯誤數字跟異常事件什麼的,也有人乾脆設成十秒左右猛抓。唉,我有時也覺得這些數字怎麼念都拗口,但現場就是如此啊。

話說光顧著頻率也不夠啦。有些資料內容本身超重要,比如你可能很關心此刻狀態怎麼樣,可單看現在根本不夠,要一起參考最近變化速度比較保險,有時還要拉長整條時間線去判斷趨勢——到底是在逐漸惡化還是偶爾亂竄?想起來頭都痛。

層次感也是個學問。有公司死盯底層硬體(伺服器、主機那些),但老練的人會再往上觀察,比方說服務表現或使用者端反饋。有趣的是,有時角度不同,同一件小插曲就神奇地被藏住了……好吧,也許這聽起來瑣碎,但如果能抓住幾個核心要點,其實真能少踩不少坑。嗯,就先寫到這吧,又累了。

其實這狀況挺普遍的啦。欸,有時寫到這邊突然想起以前那種伺服器又大又慢,那個時代什麼都拖很久,所以大家對監控也沒太多要求,反正出問題處理速度慢到天荒地老。但現在咧?應用服務動不動一分鐘內就恢復正常,可工具還活在過去,好像時間沒前進一樣。有點無奈。

現代系統自己會自動伸縮嘛,有些波動快得像眨眼一樣,一下子問題發生,一下子又修好。如果你的監控還卡在十年前的步調,那缺漏的細節大概比你想像得多吧。嗯……講著講著忽然想到昨天看到某篇文章也是這樣,不過扯遠了,拉回來——重點就是別偷懶。

如果你看到這裡突然心裡一震,「欸,好像我家情況差不多?」其實也不用太緊張,可以自己簡單檢查一下。例如你家的監控到底多久才掃描一次CPU或記憶體?據說一般能忍受的極限,大概是一分鐘內要掃一次;網路流量變化勤快點,大致半分鐘上下比較保險;至於應用程式回應速度,有些人甚至堅持十多秒就該盯一回;錯誤數字跟異常事件什麼的,也有人乾脆設成十秒左右猛抓。唉,我有時也覺得這些數字怎麼念都拗口,但現場就是如此啊。

話說光顧著頻率也不夠啦。有些資料內容本身超重要,比如你可能很關心此刻狀態怎麼樣,可單看現在根本不夠,要一起參考最近變化速度比較保險,有時還要拉長整條時間線去判斷趨勢——到底是在逐漸惡化還是偶爾亂竄?想起來頭都痛。

層次感也是個學問。有公司死盯底層硬體(伺服器、主機那些),但老練的人會再往上觀察,比方說服務表現或使用者端反饋。有趣的是,有時角度不同,同一件小插曲就神奇地被藏住了……好吧,也許這聽起來瑣碎,但如果能抓住幾個核心要點,其實真能少踩不少坑。嗯,就先寫到這吧,又累了。

自動擴容小調整,錯誤一夜消失無蹤影

有些人會問:「這個系統到底有沒有在好好運作?」嗯,其實這問題聽起來簡單,背後藏的意思大概就兩種。第一,程式本身還跑得動嗎?第二,用戶用這服務卡不卡?唉,有時候看監控數字高興得太早,結果現實不是那麼一回事——不知道是不是只有我會這樣分心想東想西。

偶爾你會聽到有人說,不要只盯著平均值嘛。有些狀況就躲在角落死不出來,比如速度最慢那幾筆請求,好吧,誰平常無聊去看那個呢?如果只是掃一眼整體數據,很多問題根本挖不出來。啊對了,我自己也經常這樣偷懶。其實那些突發異常,是用很細的觀察窗口才比較容易抓到,不然一下子就被資料大海淹沒了,唔。

還有人提過,在測試環境下乾脆故意搞點小麻煩,看看到底監控能不能即時反映。欸,如果什麼都沒看到,也許該考慮把監控頻率調高一點吧。不然一些突如其來的情形,一閃就溜走了。講是這樣講啦,但真的要改設定又覺得有點懶,就是那種「算了先擱著」的心情。

說到底,其實讓團隊頭大的往往不是技術本身。有時候問題反而在人、在溝通上面。我以前遇過類似狀況——伺服器和程式查了一輪都沒找到原因,到最後大家才發現一直以為監控報告寫的就是全部真相。但誰想到,其實用戶早就在反應狀況,只是沒人特別放在心上……工程師們忙得焦頭爛額,被指責半天;維運的人也老是查錯方向。唉,感覺很多地方偶爾都會遇到類似的亂象吧。

偶爾你會聽到有人說,不要只盯著平均值嘛。有些狀況就躲在角落死不出來,比如速度最慢那幾筆請求,好吧,誰平常無聊去看那個呢?如果只是掃一眼整體數據,很多問題根本挖不出來。啊對了,我自己也經常這樣偷懶。其實那些突發異常,是用很細的觀察窗口才比較容易抓到,不然一下子就被資料大海淹沒了,唔。

還有人提過,在測試環境下乾脆故意搞點小麻煩,看看到底監控能不能即時反映。欸,如果什麼都沒看到,也許該考慮把監控頻率調高一點吧。不然一些突如其來的情形,一閃就溜走了。講是這樣講啦,但真的要改設定又覺得有點懶,就是那種「算了先擱著」的心情。

說到底,其實讓團隊頭大的往往不是技術本身。有時候問題反而在人、在溝通上面。我以前遇過類似狀況——伺服器和程式查了一輪都沒找到原因,到最後大家才發現一直以為監控報告寫的就是全部真相。但誰想到,其實用戶早就在反應狀況,只是沒人特別放在心上……工程師們忙得焦頭爛額,被指責半天;維運的人也老是查錯方向。唉,感覺很多地方偶爾都會遇到類似的亂象吧。

你的監控真能看到嗎?人性與工具的拉鋸戰

有時候我真的覺得,管理層到底在看什麼啊?唉,可能他們也沒惡意啦,就是那套監控系統日日夜夜亮著「一切都沒問題」的燈號,大家久了自然也就信了。嗯……直到某天,突然有用戶跳出來、斷斷續續地反映一些怪異現象,那瞬間才發現原來我們一直都瞎了眼(還挺諷刺的)。其實我剛開始還以為只是個別狀況,結果越查越不對勁——怎麼會這麼多看不到的漏洞?啊,我又扯遠了,拉回正題。

這種經歷讓人開始懷疑那些完美無缺的監控畫面,到底能不能信賴。欸,有時儀表板一片綠油油,用戶卻抱怨連連,你說到底誰有問題?根本不是用戶腦袋壞掉,大概率就是我們自己感官遲鈍罷了。有些同事後來私下嘆氣說,其實早點投資更好的監控工具,也許能省下不少煩惱和工時。畢竟生產環境裡,一個小故障藏著拖將近兩週沒修好,到最後損失絕對比買幾套新軟體還要高(想想心情都不好)。

唉,每次聊到這種經驗談,就像碎念一樣,不過大致上就是:首先,「全部正常」那張圖,很容易騙人啦,本來能看到的資訊就有限嘛;然後,如果故障發生得飛快又短暫,一輪檢查間隔太長根本抓不住那些瞬息萬變的小插曲。有時候講到這裡腦子會飄掉——等等,我剛剛是不是又漏講什麼?哦對,願意主動給你反饋的用戶,多半是真的遇到麻煩,不然誰閒著沒事寫投訴信自找麻煩呢?

另外,好像所有東西理論上都該放進監控範圍裡頭,包括伺服器硬體、應用程式、還有最終用戶體驗,缺一不可。不知道為什麼,每次有人問我「監控是不是設好了」,我腦中總浮現那種假裝穩當但其實漏洞百出的畫面。最後嘛,有些人老是忘記定期測試自己的監控設置,到底警報能不能準確抓住自己真正在乎的問題——其實這才是關鍵,可惜常常被忽略。

偶爾聽到別人在會議裡輕描淡寫:「我們系統顯示沒異常啊。」很想反問一句:「那你們多久檢查一次?」通常答案會讓你滿臉黑線……好吧,也只能笑笑收場。

這種經歷讓人開始懷疑那些完美無缺的監控畫面,到底能不能信賴。欸,有時儀表板一片綠油油,用戶卻抱怨連連,你說到底誰有問題?根本不是用戶腦袋壞掉,大概率就是我們自己感官遲鈍罷了。有些同事後來私下嘆氣說,其實早點投資更好的監控工具,也許能省下不少煩惱和工時。畢竟生產環境裡,一個小故障藏著拖將近兩週沒修好,到最後損失絕對比買幾套新軟體還要高(想想心情都不好)。

唉,每次聊到這種經驗談,就像碎念一樣,不過大致上就是:首先,「全部正常」那張圖,很容易騙人啦,本來能看到的資訊就有限嘛;然後,如果故障發生得飛快又短暫,一輪檢查間隔太長根本抓不住那些瞬息萬變的小插曲。有時候講到這裡腦子會飄掉——等等,我剛剛是不是又漏講什麼?哦對,願意主動給你反饋的用戶,多半是真的遇到麻煩,不然誰閒著沒事寫投訴信自找麻煩呢?

另外,好像所有東西理論上都該放進監控範圍裡頭,包括伺服器硬體、應用程式、還有最終用戶體驗,缺一不可。不知道為什麼,每次有人問我「監控是不是設好了」,我腦中總浮現那種假裝穩當但其實漏洞百出的畫面。最後嘛,有些人老是忘記定期測試自己的監控設置,到底警報能不能準確抓住自己真正在乎的問題——其實這才是關鍵,可惜常常被忽略。

偶爾聽到別人在會議裡輕描淡寫:「我們系統顯示沒異常啊。」很想反問一句:「那你們多久檢查一次?」通常答案會讓你滿臉黑線……好吧,也只能笑笑收場。

總結:相信用戶、懷疑儀表板、別讓問題溜走

檢查之間到底發生了什麼?唉,這種問題有時候真的讓人腦袋一片空白。你不覺得嗎?有些答案好像就躲在那些看起來沒什麼的間隙裡頭,明明盯著螢幕很久,可是偏偏就是找不到蛛絲馬跡。嗯,其實我自己也常遇到那種監控完全偵測不到的怪事——欸,是不是只有我會這樣懷疑?但據說,這類迷團出現的頻率,比我們想像中還高很多,有點煩躁吧。

有人提過,只要監控系統能跟上應用程式變化速度,大概可以減少一些死角。不過話說回來,要每次都做到滴水不漏,好像又太理想主義了。啊,我剛才本來在想午餐吃什麼……欸對啦,拉回來講,其實真的沒辦法保證萬無一失,每次排查都是賭命(誇張了)。

如果你腦中突然蹦出什麼奇葩想法、或者單純只是無聊想跟人聊兩句,也許可以考慮去Linkedin碰碰運氣——我自己就偶爾會收到幾條訊息。有些人直接開聊,也挺隨性的。說到這個,最近整理了一份DevOps工程師可能用得到的小工具清單,那東西全丟在GitHub上,包括排查問題指令、腳本還有一些經驗備忘錄。嗯,不知道為什麼想到小時候集郵,欸…反正有興趣的人可以自己翻看看。

如果覺得有用順手點個星星也行,不過沒有強迫症的話其實也不用特別去管它啦。我偶爾會寫點心得分享,有人說讀起來還算受用,不確定是不是客套話。如果哪天真的覺得內容對你派得上用場,也歡迎請我喝杯咖啡(大概吧)。不是每個人都需要,但總有人卡在某個神奇詭異的位置動彈不得——唉,人類就是容易陷進去。

有人提過,只要監控系統能跟上應用程式變化速度,大概可以減少一些死角。不過話說回來,要每次都做到滴水不漏,好像又太理想主義了。啊,我剛才本來在想午餐吃什麼……欸對啦,拉回來講,其實真的沒辦法保證萬無一失,每次排查都是賭命(誇張了)。

如果你腦中突然蹦出什麼奇葩想法、或者單純只是無聊想跟人聊兩句,也許可以考慮去Linkedin碰碰運氣——我自己就偶爾會收到幾條訊息。有些人直接開聊,也挺隨性的。說到這個,最近整理了一份DevOps工程師可能用得到的小工具清單,那東西全丟在GitHub上,包括排查問題指令、腳本還有一些經驗備忘錄。嗯,不知道為什麼想到小時候集郵,欸…反正有興趣的人可以自己翻看看。

如果覺得有用順手點個星星也行,不過沒有強迫症的話其實也不用特別去管它啦。我偶爾會寫點心得分享,有人說讀起來還算受用,不確定是不是客套話。如果哪天真的覺得內容對你派得上用場,也歡迎請我喝杯咖啡(大概吧)。不是每個人都需要,但總有人卡在某個神奇詭異的位置動彈不得——唉,人類就是容易陷進去。