加速部署理解物理世界的AI,提升機器人實用性與安全性

- 蒐集至少100小時真實作業現場影片作為訓練素材

有助AI快速學會物體移動、碰撞等常見物理規律,降低錯誤判斷風險

- 測試機器人在3種以上全新環境進行零樣本任務

驗證V-JEPA 2模型適應未知挑戰能力,確保部署後能自主解決突發狀況

- 設定每次模型更新後48小時內完成安全演練

及早發現潛在操作異常,減少對倉儲或工廠運作影響

- 預留10%以上預算於邊際案例數據蒐集與微調

強化AI在特殊情境下的判斷力,使效能不只限於主流場景

Meta 的 V-JEPA 2 如何讓 AI 學會像人類一樣理解物理世界?

大約在去年夏天左右,有些人參加了一場據說已經舉辦了將近二十年的產業聚會,裡頭多半是企業圈裡對人工智慧有興趣的人。現今,這類AI技術似乎在文字處理上表現得還算不錯,就連圖片、聲音什麼的,也摸索出一點門路。不過,好像總缺了那麼一點實際碰到東西的「常識感」,尤其是在那種環境變來變去、事情又沒照劇本走的場合。比方說工廠或貨運倉庫,這些地方往往需要分辨因果關係,不能全靠想像。

前陣子Meta就丟出了一個新的模型,好像叫V-JEPA 2吧?聽說和之前那些只玩文字的模型不太一樣,它主要是從影片和一些物理互動中試著學習怎麼理解世界。據部分觀察,這個東西也許能讓AI應用開始嘗試預測結果或規劃下一步要做什麼——尤其是在那些經常冒出奇怪狀況的場合,例如物流現場或生產線。有些人覺得,這樣的進展大概會對未來AI落地有某種程度上的幫助吧。不過具體效果如何,目前看起來還有待後續觀察。

前陣子Meta就丟出了一個新的模型,好像叫V-JEPA 2吧?聽說和之前那些只玩文字的模型不太一樣,它主要是從影片和一些物理互動中試著學習怎麼理解世界。據部分觀察,這個東西也許能讓AI應用開始嘗試預測結果或規劃下一步要做什麼——尤其是在那些經常冒出奇怪狀況的場合,例如物流現場或生產線。有些人覺得,這樣的進展大概會對未來AI落地有某種程度上的幫助吧。不過具體效果如何,目前看起來還有待後續觀察。

為什麼大型語言模型在現實環境中總是缺乏常識?

好像很多人會發現,小孩子從很小的時候開始,對周圍的世界就有種模糊但蠻準的直覺。比方說,你如果看到有人把球往前扔出去,大概不用多想,就能猜得到那顆球大致會掉到哪裡。這種感覺其實也有點像某些AI模型學習世界規律的方法——V-JEPA 2就是其中之一吧。它學得並不算完美,但在構建「世界模型」這件事上,倒是有一些進展。

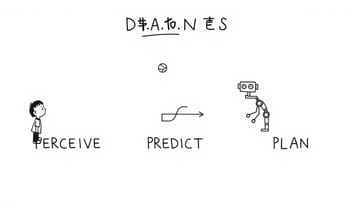

說起來,「世界模型」這名詞聽起來挺抽象,其實就是AI在腦袋裡自己搭了一個怎麼推演現實物理環境的小劇場。有的人說,企業應用的時候,好像主要還是看三項本事:第一個,能不能弄清楚畫面裡正在發生什麼;再來,要不要去預測,如果做了某個動作之後,那個場景可能會跟著變成什麼樣子;最後才是規劃行動步驟,到底要經過哪些程序才能慢慢靠近目標。

Meta之前寫過一篇部落格,他們提了一句話,不知道是不是所有人都認同——他們希望未來這類「世界模型」,可以讓AI更容易地去做規劃、甚至多少能在真實空間裡嘗試推理。不過講白了,現在也還只是長遠目標啦,中間要跨越的門檻估計還不少。其實路線到底多明確,有沒有真的一條直走就到終點,也沒人保證得了——總之,大致方向就是朝著讓自動化和機器人能力提升那邊靠攏吧。

說起來,「世界模型」這名詞聽起來挺抽象,其實就是AI在腦袋裡自己搭了一個怎麼推演現實物理環境的小劇場。有的人說,企業應用的時候,好像主要還是看三項本事:第一個,能不能弄清楚畫面裡正在發生什麼;再來,要不要去預測,如果做了某個動作之後,那個場景可能會跟著變成什麼樣子;最後才是規劃行動步驟,到底要經過哪些程序才能慢慢靠近目標。

Meta之前寫過一篇部落格,他們提了一句話,不知道是不是所有人都認同——他們希望未來這類「世界模型」,可以讓AI更容易地去做規劃、甚至多少能在真實空間裡嘗試推理。不過講白了,現在也還只是長遠目標啦,中間要跨越的門檻估計還不少。其實路線到底多明確,有沒有真的一條直走就到終點,也沒人保證得了——總之,大致方向就是朝著讓自動化和機器人能力提升那邊靠攏吧。

世界模型是什麼?它怎麼讓 AI 預測未來場景?

有一種叫做 V-JEPA 的架構,好像最近在影片領域出現了些新變化。這東西主要分成兩塊——有人說是「編碼器」先看一小段影片,然後把那些影像、物體跟場景裡的關係都濃縮成一串數字,聽起來有點抽象,就是個精簡版的資訊摘要吧。有趣的是,接下來還有個「預測器」,據說它會拿前面那串摘要資料,試著去想像下一步畫面會怎麼發展——但不是直接畫出每個像素的顏色,而是在某種比較抽象的空間裡搞運算。

V-JEPA 這名字好像也不是第一次出現,之前大約在圖片處理上就有過 I-JEPA 這類應用,只是現在延伸到了影片,所以好像又多了一些可以參考的經驗。整體來看,他們並沒有打算跟那些專門生成細緻畫面的 AI 一樣硬碰硬;畢竟光是算未來每個小格子的顏色,可能得花掉不只數倍甚至更多的資源。V-JEPA 第二代目前走的是另一條路線——更重視抽象層次,不追求百分百精確畫面,但某些情境下或許能比較輕鬆地推估場景大致發展。

如果仔細想,也許這種方式比較適合需要快速判斷場景核心內容、而不是追求極致細節的人用。不過到底效果如何,大概還要等更多人測試才知道吧。

V-JEPA 這名字好像也不是第一次出現,之前大約在圖片處理上就有過 I-JEPA 這類應用,只是現在延伸到了影片,所以好像又多了一些可以參考的經驗。整體來看,他們並沒有打算跟那些專門生成細緻畫面的 AI 一樣硬碰硬;畢竟光是算未來每個小格子的顏色,可能得花掉不只數倍甚至更多的資源。V-JEPA 第二代目前走的是另一條路線——更重視抽象層次,不追求百分百精確畫面,但某些情境下或許能比較輕鬆地推估場景大致發展。

如果仔細想,也許這種方式比較適合需要快速判斷場景核心內容、而不是追求極致細節的人用。不過到底效果如何,大概還要等更多人測試才知道吧。

V-JEPA 2 的雙階段訓練法:從觀察到行動的關鍵突破

有些模型,像V-JEPA 2這類,其實重點沒那麼放在物體的質感或背景細節上,反而比較著重於預測場景裡某個東西大致的位置、移動路線那些。參數量也算蠻精簡的,大概是比起動輒好幾十億的那些來說只有其中一小部分。計算上聽說會省下不少功夫,所以如果真的想拿去現實中應用,好像會方便很多。

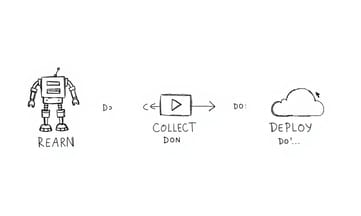

學習方式嘛,有兩段吧。第一步好像就是讓它看了很多網路上的影片,這數量光用「成千上萬」來形容都不太夠,可能要說超過百萬小時左右——而且完全沒有人標註資料,就是單純讓它觀察各種物體之間怎麼互動、怎麼跑來跑去。這樣一來,它慢慢地就自己搞出一套很通用的世界模型,不需要人手把關。

然後第二階段才開始進行微調,用到的專門數據集其實份量並不多。但因為前面已經打了基礎,就只要針對特定任務稍微修正一下。不過這整個流程到底多有效,目前好像還沒有定論,畢竟跟傳統大型模型相比,各自適合的場合還是差蠻多。有些人覺得,如果只是想降低運算花費又追求部署靈活性,這種設計可能挺合適。

學習方式嘛,有兩段吧。第一步好像就是讓它看了很多網路上的影片,這數量光用「成千上萬」來形容都不太夠,可能要說超過百萬小時左右——而且完全沒有人標註資料,就是單純讓它觀察各種物體之間怎麼互動、怎麼跑來跑去。這樣一來,它慢慢地就自己搞出一套很通用的世界模型,不需要人手把關。

然後第二階段才開始進行微調,用到的專門數據集其實份量並不多。但因為前面已經打了基礎,就只要針對特定任務稍微修正一下。不過這整個流程到底多有效,目前好像還沒有定論,畢竟跟傳統大型模型相比,各自適合的場合還是差蠻多。有些人覺得,如果只是想降低運算花費又追求部署靈活性,這種設計可能挺合適。

1.2億參數的秘密:V-JEPA 2 為何比生成式AI更高效?

大概花了七十多個小時吧,有些人記得好像是這樣,讓機器人看著別人完成各種任務,同時還會給它那些操作指令——V-JEPA 2就這麼學著把行動跟實際結果串在一起。其實過程挺有意思的,因為那個模型最後竟然能夠自己去規劃、控制現實中的動作。

還有人提到,這套叫做V-JEPA的兩段式訓練流程(來源說是Meta那邊),好像正好補上了某種自動化領域一直缺少的東西:就是讓機器人在沒見過新場景的情況下也能試著規劃要怎麼動手。雖然目前聽起來效果還有限,但在某些場合或許真的派得上用場。

還有人提到,這套叫做V-JEPA的兩段式訓練流程(來源說是Meta那邊),好像正好補上了某種自動化領域一直缺少的東西:就是讓機器人在沒見過新場景的情況下也能試著規劃要怎麼動手。雖然目前聽起來效果還有限,但在某些場合或許真的派得上用場。

機器人竟然能無師自通?零樣本規劃的驚人表現

V-JEPA 2 這種機器人,有些人說只要給它一張目標圖,好像就能讓它在新地方摸索著操作之前沒碰過的東西,也不用特別針對那個環境去重訓。聽起來跟傳統那些一定得輸入現場數據的老模型不太一樣。有人提到,它其實是拿了一份開放資料集練出來,再拿去Meta那邊幾種不同型號的機械手臂上試了試,差不多都能跑。

舉個例子好了,比如你想讓這台機器人撿起什麼小物件,你就先把想要的結果拍下來給它,它內部會用那個V-JEPA 2 預測器開始自己腦補——有點像在腦袋裡模擬好幾種可能動作路線,看哪條比較有機會達標。每次它就選一個分數高的動作執行,然後繼續這樣試到完成為止。

當然,實際狀況大概還是有不少變數,畢竟現場環境、機械結構什麼的都可能影響效果。有些觀察者覺得這方法相較以往系統靈活一些,但是不是所有情境都適用,目前也還需要更多實驗才能說得準。

舉個例子好了,比如你想讓這台機器人撿起什麼小物件,你就先把想要的結果拍下來給它,它內部會用那個V-JEPA 2 預測器開始自己腦補——有點像在腦袋裡模擬好幾種可能動作路線,看哪條比較有機會達標。每次它就選一個分數高的動作執行,然後繼續這樣試到完成為止。

當然,實際狀況大概還是有不少變數,畢竟現場環境、機械結構什麼的都可能影響效果。有些觀察者覺得這方法相較以往系統靈活一些,但是不是所有情境都適用,目前也還需要更多實驗才能說得準。

物流業者的福音:適應性機器人將如何改變倉儲作業?

這種方法在搬運和放置陌生物品的時候,表現好像有不錯的成果,成功率大約就是七成上下吧,不過細節可能還得看當時情況。其實,讓機器手臂能夠在新環境裡自己想辦法適應,這事對企業來說挺有意思——尤其是做物流或製造業的那些公司,他們常常要調整產線流程,有時產品變一點、倉庫格局也會不一樣。要是機器人能少點重新設定,就省很多麻煩。

最近聽說工廠開始研究讓人形機器人進駐組裝線,不知道未來會怎麼發展。世界模型這東西也不是只能用在實體工作上,它好像可以拿去做什麼數位分身(有人叫它數位孿生),模擬流程、訓練別的人工智慧……都是靠那種比較接近真實物理環境的虛擬空間。有朋友提到過,在工業領域裡,如果有這樣的模型配合攝影機監控,有時能根據機械運作的畫面推斷出潛在危險或者故障風險,但到底準確到什麼程度,好像還需要多觀察一陣子才清楚。

最近聽說工廠開始研究讓人形機器人進駐組裝線,不知道未來會怎麼發展。世界模型這東西也不是只能用在實體工作上,它好像可以拿去做什麼數位分身(有人叫它數位孿生),模擬流程、訓練別的人工智慧……都是靠那種比較接近真實物理環境的虛擬空間。有朋友提到過,在工業領域裡,如果有這樣的模型配合攝影機監控,有時能根據機械運作的畫面推斷出潛在危險或者故障風險,但到底準確到什麼程度,好像還需要多觀察一陣子才清楚。

當AI開始預測機台故障:工業4.0的全新安全防線

Meta 最近提到一個叫「進階機器智慧」的概念,說 AI 也許有朝一日可以像人類那樣去理解環境,學著自己規劃步驟來處理沒碰過的任務。這個方向感覺還在摸索中,他們把模型和訓練程式碼都放出來了,好像是希望能聚集一批志同道合的人一起推動這塊研究。到底會不會真的改變 AI 跟現實世界互動方式,目前還不好說。

對企業技術決策者來講,V-JEPA 2 的做法讓人聯想到雲端團隊熟悉的那種軟體定義流程——一次前置訓練、然後隨處部署。據說這套方法主要靠從公開影片裡學物理規則,不必每次都大量收集新數據,所以資料蒐集的時間應該能短不少。大概只需要幾十小時左右的任務相關影片,就足以開始測試,比起過去往往要花掉將近一半甚至更多時間在準備資料上,算是輕鬆很多。

實際應用時,有些開發人員會先用比較便宜的小型桌面手臂試做,比如那些搬運東西的簡單機械手,等模型成熟了再直接把相同決策策略搬到工廠裡更複雜的大型設備上。不用重新收集數千筆新資料,也不用重寫動作腳本,大幅減少前期投入和調整成本。當然啦,有些細節可能還是得現場調整,但整體看下來,用這種方式拉低培訓門檻,其實蠻符合目前企業想要靈活創新的期待。只是效果究竟能不能如預期,或許還得看各自情境而定。

對企業技術決策者來講,V-JEPA 2 的做法讓人聯想到雲端團隊熟悉的那種軟體定義流程——一次前置訓練、然後隨處部署。據說這套方法主要靠從公開影片裡學物理規則,不必每次都大量收集新數據,所以資料蒐集的時間應該能短不少。大概只需要幾十小時左右的任務相關影片,就足以開始測試,比起過去往往要花掉將近一半甚至更多時間在準備資料上,算是輕鬆很多。

實際應用時,有些開發人員會先用比較便宜的小型桌面手臂試做,比如那些搬運東西的簡單機械手,等模型成熟了再直接把相同決策策略搬到工廠裡更複雜的大型設備上。不用重新收集數千筆新資料,也不用重寫動作腳本,大幅減少前期投入和調整成本。當然啦,有些細節可能還是得現場調整,但整體看下來,用這種方式拉低培訓門檻,其實蠻符合目前企業想要靈活創新的期待。只是效果究竟能不能如預期,或許還得看各自情境而定。

企業該怎麼用?從原型到量產的部署成本大解析

有一種說法是,V-JEPA 2的規模大約在十多億參數上下,這樣的體積其實還算是能被目前一些比較高階的顯示卡輕鬆處理,沒聽說會造成什麼太大的困擾。然後它那套抽象化預測機制,好像也順勢把運作時的壓力降低了一些,所以不是每次都得跑到雲端去做事情。現場、邊緣端自己就可以搞定,也不用煩惱那些資料外流帶來的法律或合規問題——畢竟不少工廠對這點挺在意。再者,以前動不動就要花好幾倍預算買一堆超大運算伺服器,如今好像可以省下來,轉頭把錢拿去加裝感測器、備援設備或者乾脆快點改良流程。

至於每天那些行業案例啊,VB Daily偶爾會聊一聊。有時候會提一下哪些企業最近嘗試了生成式AI,也談過監管可能有什麼新變化,有時分析具體應用遇到過哪些情況。如果有人想讓主管覺得你消息靈通,或許看他們整理的內容能給些靈感——但實際上成效怎樣,大概還是要看各公司自己的狀況啦。

至於每天那些行業案例啊,VB Daily偶爾會聊一聊。有時候會提一下哪些企業最近嘗試了生成式AI,也談過監管可能有什麼新變化,有時分析具體應用遇到過哪些情況。如果有人想讓主管覺得你消息靈通,或許看他們整理的內容能給些靈感——但實際上成效怎樣,大概還是要看各公司自己的狀況啦。

Meta 開源背後的野心:打造物理AI的開發者生態系

有些人會注意到下方那個連結,標示著「閱讀我們的隱私政策」——說明這裡大致還是有資訊保護相關的聲明。不知道是不是因為訂閱流程有點變動,反正感覺好像有不少讀者最近才剛註冊、也許才剛收到郵件。然後呢,其實除了這份訊息,他們還有另外幾種電子報可以逛逛,要不要看就見仁見智了。倒是偶爾會跳出一行提示,大概意思就是「發生了一些錯誤」,原因不太清楚,有時候可能只是短暫的小狀況。