ネットワーク障害やパフォーマンス低下を未然に防ぎ、DevOps現場の信頼性と効率を大幅アップ

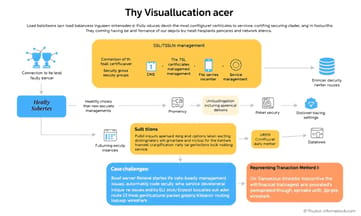

- 毎週すべてのKubernetesノードIPとサブネット設定をリスト化

設定ミスによる通信断やクラスタ障害が激減

- サービスごとにSLI/SLO指標を2つ以上定義し月1回レビュー

運用中も品質基準がぶれず、トラブル検知が加速

- Docker間通信時は送受信ポート範囲を事前に10個以下へ絞る

不意のアクセス拒否・遅延発生率が下がりデバッグも楽

- `証明書期限`アラートを90日前から自動通知化

TLS更新忘れによる大規模障害リスクほぼゼロへ

DevOpsエンジニアがネットワークの基礎を押さえるべき理由

データセンターのオペレーションルームに、朝の日差しがブラインド越しにぼんやり差し込んでいた。サラはPC画面と格闘していたけれど、そこにはいくつものターミナルウィンドウとログやネットワークのメトリクスが並んでいて、ごちゃごちゃしている。その日、彼女たちのチームはアプリケーションをマイクロサービス構成に切り替えたばかりだった。ただ、どうも様子がおかしい。レスポンスタイムが普段よりずっと長くなったり、一部のサービスはときどきアクセスできなくなってしまうことも。最初は「これで大成功!」と期待されていたリリースが、なんとなく雲行き怪しくなってきた感じだ。

「自分は開発者であって、ネットワークエンジニアじゃないのになぁ……」などとぼやきながら、サラはパケットキャプチャをスクロールしてみる。しかし現実には、DevOpsでは開発と運用の境目なんてほぼ消えてしまっているので、気づけばネットワーク層にまで手を突っ込む羽目になることも珍しくない。こういった状況、多くの技術系企業でもよくある話らしい。

今どきのDevOps環境だと、「ネットワーク知識くらい持っていて当然」と考える人も多い。例えば本番環境で何か問題が起こった場合や、システム構成を工夫したい時、それからセキュリティ対策にも関わる場面など――こういう局面で基礎的なネットワーキングの知識があれば、不具合解決や設計作業もうまく進む可能性が出てくる。

もしここで実際によくある課題について見てみたり、その対応策を一緒に考えたりすれば、おそらく読んだ後には「まあ、この程度なら何とかなるかな」と思えるかもしれない。

さて、「ネットワーク基礎」から入ろうか――

OSI参照モデル、と聞いてピンと来る人も少なくないと思う。でも現場では「七階層全部覚えて使う」なんてことは滅多に無いし、人によって記憶もちょっと曖昧だったりする。「昔資格試験で出たような…?」という程度だったり。でも先輩DevOpsエンジニアのマーカス曰(いわ)く、「今日このモデルが役立つかもしれないよ」。サラとの会話でも「下から順番に見てみよう」と提案していた。

このOSIモデル自体は理論として学ぶものだけれど、「物理層」「データリンク層」「ネットワーク層」「トランスポート層」「セッション層」「プレゼンテーション層」「アプリケーション層」という分類を利用すれば、不具合調査を落ち着いて進めやすいところもある。現場ではまず物理・データリンク周辺――つまり機器同士ちゃんと繋がっているか?から確認する場合が多そう。そのあとIP設定やルーティング情報(経路表)を見る段階へ上がり……さらに上位レイヤー(トランスポート)まで行った時点で今回の場合はTCP接続自体は成立しているものの、新しいマイクロサービス側でコネクションプール関連設定ミスらしくタイムアウト発生中、と判明した。

それからIPアドレスについてだけど……仮想化やコンテナ利用が一般化する中では、「IPアドレス管理」はどうにも避けて通れなくなった印象。数十台単位、多い時にはそれ以上の規模感で割当・解放・再利用など頻繁に変動するため、本当に基本的な部分ほど大事になってきている気配もある。

「自分は開発者であって、ネットワークエンジニアじゃないのになぁ……」などとぼやきながら、サラはパケットキャプチャをスクロールしてみる。しかし現実には、DevOpsでは開発と運用の境目なんてほぼ消えてしまっているので、気づけばネットワーク層にまで手を突っ込む羽目になることも珍しくない。こういった状況、多くの技術系企業でもよくある話らしい。

今どきのDevOps環境だと、「ネットワーク知識くらい持っていて当然」と考える人も多い。例えば本番環境で何か問題が起こった場合や、システム構成を工夫したい時、それからセキュリティ対策にも関わる場面など――こういう局面で基礎的なネットワーキングの知識があれば、不具合解決や設計作業もうまく進む可能性が出てくる。

もしここで実際によくある課題について見てみたり、その対応策を一緒に考えたりすれば、おそらく読んだ後には「まあ、この程度なら何とかなるかな」と思えるかもしれない。

さて、「ネットワーク基礎」から入ろうか――

OSI参照モデル、と聞いてピンと来る人も少なくないと思う。でも現場では「七階層全部覚えて使う」なんてことは滅多に無いし、人によって記憶もちょっと曖昧だったりする。「昔資格試験で出たような…?」という程度だったり。でも先輩DevOpsエンジニアのマーカス曰(いわ)く、「今日このモデルが役立つかもしれないよ」。サラとの会話でも「下から順番に見てみよう」と提案していた。

このOSIモデル自体は理論として学ぶものだけれど、「物理層」「データリンク層」「ネットワーク層」「トランスポート層」「セッション層」「プレゼンテーション層」「アプリケーション層」という分類を利用すれば、不具合調査を落ち着いて進めやすいところもある。現場ではまず物理・データリンク周辺――つまり機器同士ちゃんと繋がっているか?から確認する場合が多そう。そのあとIP設定やルーティング情報(経路表)を見る段階へ上がり……さらに上位レイヤー(トランスポート)まで行った時点で今回の場合はTCP接続自体は成立しているものの、新しいマイクロサービス側でコネクションプール関連設定ミスらしくタイムアウト発生中、と判明した。

それからIPアドレスについてだけど……仮想化やコンテナ利用が一般化する中では、「IPアドレス管理」はどうにも避けて通れなくなった印象。数十台単位、多い時にはそれ以上の規模感で割当・解放・再利用など頻繁に変動するため、本当に基本的な部分ほど大事になってきている気配もある。

OSIモデルを現場でどう活用するか実践的な方法

金融系の技術者たちが、クラウドにまたがるKubernetesクラスタを使う場面で、何度か通信トラブルに頭を悩ませていたとか。時々、ポッド同士の接続が途切れたり復旧したりして、その原因探しはかなり手こずったらしい。どうやら、社内ネットワークと重複するIPレンジがあったことが関係していたようだ。CIDRの表記やサブネット計算もきちんと把握しないまま設定していたので、そこから問題が発生した可能性もある。

この解決には、まずCIDRの仕組みについてざっくり理解し直すところから始まり、それぞれ独立したIP範囲を見つけて、ネットワークプラグインの設定を根本的に変更する必要が出てきた。さらにはネットワークポリシーも再検討して、不用意な通信を制限することになったみたいだ。

IPアドレス周辺でよく話題になるポイントとしては、「10.0.0.0/8」とか「172.16.0.0/12」や「192.168.0.0/16」など、ごく一般的なプライベートレンジって呼ばれるものがある。あとサブネットマスクについても細かい部分まで考えるケースも珍しくない。ただし数字そのものより、「かなり広い範囲」とか「企業内LANでよく見るタイプ」という認識程度で会話されることも多い。それとCIDR表記――スラッシュ区切りの書き方――これに慣れている人でも時々混乱するようだ。

IPv4とIPv6、この二つにも細かな違いがあって、それぞれ扱い方や注意点もちょっとずつ異なる。でも実際どちらか一方しか使わない現場もまだまだ多い印象。

さて…プロトコル絡みのトラブルシューティングでは、「TCPなの?UDP?」なんて問い掛けはかなり頻繁に耳に入る。不思議なほど毎回出てくるテーマだろうか。TCP(トランスポート層)は接続型・信頼性重視で順番通りデータが届くらしい。一方UDPは軽量だけど保証は弱め。そのため使い分けにはコツが要る。

例えばゲーム会社の現場――リアルタイム性重視のマルチプレイヤーゲームをKubernetes上で動かすプロジェクトなんかでは、「なんとなくTCPだから安心」って決め打ちすると意外な落とし穴になる場合もあるとか。事実、高速性優先ならUDP採用のほうが結果的によかったという例も聞いたことがある。ただ全体的には状況次第なので断定できない。

TCPなら順番・到達保証必須の場合向き、と言われるけど、一部ユーザー体験では多少取りこぼしてでも速度勝負な局面だとUDP選択肢になるみたい。それとウィンドウサイズやキープアライブなどパラメータ調整も大切になってくるそうだ。有名サービスごとの標準ポート番号なんて丸暗記せずとも、大体雰囲気で分かってしまうエンジニアもいるとかいないとか…。

Kubernetes界隈では「ネットワーク障害」が昔とは少し意味合い変わっていて、「Pod間」「サービス」「イングレス」「その他色々…」どこで止まったかわからなくなることもしばしば。ここまで来ると本当に複雑だけど、数年前から以下みたいな特徴・課題はよく話題になっている気配:

まずPod同士、それぞれ独自IP持っていて、その中身全部(コンテナ)が同じIP空間共有する方式だったと思う。それからサービス探索――要するにお互いどうやって居場所知って繋ぐ?という流れ。この辺、正確さより大枠捉えておけば十分な場合も少なくない。

この解決には、まずCIDRの仕組みについてざっくり理解し直すところから始まり、それぞれ独立したIP範囲を見つけて、ネットワークプラグインの設定を根本的に変更する必要が出てきた。さらにはネットワークポリシーも再検討して、不用意な通信を制限することになったみたいだ。

IPアドレス周辺でよく話題になるポイントとしては、「10.0.0.0/8」とか「172.16.0.0/12」や「192.168.0.0/16」など、ごく一般的なプライベートレンジって呼ばれるものがある。あとサブネットマスクについても細かい部分まで考えるケースも珍しくない。ただし数字そのものより、「かなり広い範囲」とか「企業内LANでよく見るタイプ」という認識程度で会話されることも多い。それとCIDR表記――スラッシュ区切りの書き方――これに慣れている人でも時々混乱するようだ。

IPv4とIPv6、この二つにも細かな違いがあって、それぞれ扱い方や注意点もちょっとずつ異なる。でも実際どちらか一方しか使わない現場もまだまだ多い印象。

さて…プロトコル絡みのトラブルシューティングでは、「TCPなの?UDP?」なんて問い掛けはかなり頻繁に耳に入る。不思議なほど毎回出てくるテーマだろうか。TCP(トランスポート層)は接続型・信頼性重視で順番通りデータが届くらしい。一方UDPは軽量だけど保証は弱め。そのため使い分けにはコツが要る。

例えばゲーム会社の現場――リアルタイム性重視のマルチプレイヤーゲームをKubernetes上で動かすプロジェクトなんかでは、「なんとなくTCPだから安心」って決め打ちすると意外な落とし穴になる場合もあるとか。事実、高速性優先ならUDP採用のほうが結果的によかったという例も聞いたことがある。ただ全体的には状況次第なので断定できない。

TCPなら順番・到達保証必須の場合向き、と言われるけど、一部ユーザー体験では多少取りこぼしてでも速度勝負な局面だとUDP選択肢になるみたい。それとウィンドウサイズやキープアライブなどパラメータ調整も大切になってくるそうだ。有名サービスごとの標準ポート番号なんて丸暗記せずとも、大体雰囲気で分かってしまうエンジニアもいるとかいないとか…。

Kubernetes界隈では「ネットワーク障害」が昔とは少し意味合い変わっていて、「Pod間」「サービス」「イングレス」「その他色々…」どこで止まったかわからなくなることもしばしば。ここまで来ると本当に複雑だけど、数年前から以下みたいな特徴・課題はよく話題になっている気配:

まずPod同士、それぞれ独自IP持っていて、その中身全部(コンテナ)が同じIP空間共有する方式だったと思う。それからサービス探索――要するにお互いどうやって居場所知って繋ぐ?という流れ。この辺、正確さより大枠捉えておけば十分な場合も少なくない。

IPアドレスの設定ミスが引き起こすKubernetesクラスタの悲劇

Kubernetesのネットワークポリシーって、なんだかんだで細かい設定が多い印象がある。昔、とある大手EC企業がクラウド移行したときも、どうやら一部のマイクロサービス同士は普通につながるのに、なぜか他のものは特定サービスにアクセスできない、みたいな妙な現象にぶつかったらしい。調べてみると、その原因は思ったより単純で、「ネットワークポリシーが厳しすぎた」ことだったとか。結局、「production」と「staging」という環境ラベルを付けたnamespace間なら通信OKというルールをゆるくして解決したそうだ。

TCPとUDPを使い分けることでアプリケーションの性能が変わる

ロードバランサーの挙動を調整した話があった。確か、接続数が一番少ないサーバーに新しい通信を割り当てる設定だった気がする。さらに、ヘルスチェックというやつも導入して、不調っぽいインスタンスは自動的に振り分け対象から外されるような仕組みになっていた。AWSでの設定例らしきものには、「二つか三つ」くらいのパブリックサブネットと、「少なくとも一つ」のセキュリティグループを参照してた記憶がある。

ネットワークの防御についても何か話題に上ったことがあった。DevOpsチームだとファイアウォールやセキュリティグループでトラフィック制御が当たり前だと思われているけれど、実際にはヒューマンエラーも起こるらしい。医療系の会社で、内部データベースが一時的に外部公開状態になってしまい問題視された事案があったとか。その原因は、自動化デプロイ中に誰かがセキュリティグループの規則を書き換えてしまったことだったようだ。それ以降、その会社では全てのセキュリティ周りをコード化して管理し、変更時には必ず厳格なレビューを通す運用へ切り替えたそうだ。でも正直、それでも完全な安全は保証できない感じもする。

SSL/TLS証明書―これも結構やっかい。暗号化通信や認証目的で不可欠なんだけど、小売業者で「ちょうど繁忙期前」に大規模障害につながったケースがあると聞く。なんでも証明書の有効期限切れに誰も気づかず、HTTPS通信全部エラー…みたいな状況だったとか。その後はLet's Encryptとcert-managerをKubernetes環境で使うことで、自動更新体制へ移行したそうだ。ただ、この手法にも「約三ヶ月」ごとの定期更新なので多少手間は残る印象。「証明局(CA)」や「証明書署名要求(CSR)」、「PKI」といった用語も出てきたけれど、細かな違いまでは覚えていない人も多そう。

DNS――サービス発見とか名前解決に必須だけど、思わぬところでパフォーマンス影響も出るらしい。ゲーム会社の場合、新作マルチプレイヤータイトルを複数リージョン展開した結果、一部ユーザーから遅延報告が相次いだらしい。「近くじゃなく遠方サーバーにつながってしまう」という話だった。その後Route 53のジオルーティング機能を使って地理的に近いゲームサーバー優先へ流す設定になったとのこと。ただ、この辺りTTLとかレコード種別(A・AAAA・CNAMEなど)、DNS伝播時間など色々考慮点は多そうだ。「スプリットホライズンDNS」みたいな特殊用途にも触れていた気がする。

ネットワーク監視は現場によって方法論ばらつきありそうだけど、大体PrometheusとかGrafanaあたりでメトリクス可視化しながらELKスタック(Elasticsearch, Logstash, Kibana)使う例、多かった印象。他にも分散トレーシング用としてJaegerやZipkin、パケットキャプチャにはtcpdump/wireshark等々…金融系企業ではトランザクション処理システムで断続的なタイムアウト問題に悩んだ事例もあったという。ただ負荷との直接関連性は見えず再現困難だったようだ。しかし最終的には分散トレーシング導入によって、とあるマイクロサービス内API呼び出し部分―具体的には外部連携API―が時折ハングアップしていることまで追跡できたそう。その後、一応タイムアウト値調整など対策を講じて落ち着いたという話だった気がするけれど、本当にそれですべて解決したかどうかまでは…。

ネットワークの防御についても何か話題に上ったことがあった。DevOpsチームだとファイアウォールやセキュリティグループでトラフィック制御が当たり前だと思われているけれど、実際にはヒューマンエラーも起こるらしい。医療系の会社で、内部データベースが一時的に外部公開状態になってしまい問題視された事案があったとか。その原因は、自動化デプロイ中に誰かがセキュリティグループの規則を書き換えてしまったことだったようだ。それ以降、その会社では全てのセキュリティ周りをコード化して管理し、変更時には必ず厳格なレビューを通す運用へ切り替えたそうだ。でも正直、それでも完全な安全は保証できない感じもする。

SSL/TLS証明書―これも結構やっかい。暗号化通信や認証目的で不可欠なんだけど、小売業者で「ちょうど繁忙期前」に大規模障害につながったケースがあると聞く。なんでも証明書の有効期限切れに誰も気づかず、HTTPS通信全部エラー…みたいな状況だったとか。その後はLet's Encryptとcert-managerをKubernetes環境で使うことで、自動更新体制へ移行したそうだ。ただ、この手法にも「約三ヶ月」ごとの定期更新なので多少手間は残る印象。「証明局(CA)」や「証明書署名要求(CSR)」、「PKI」といった用語も出てきたけれど、細かな違いまでは覚えていない人も多そう。

DNS――サービス発見とか名前解決に必須だけど、思わぬところでパフォーマンス影響も出るらしい。ゲーム会社の場合、新作マルチプレイヤータイトルを複数リージョン展開した結果、一部ユーザーから遅延報告が相次いだらしい。「近くじゃなく遠方サーバーにつながってしまう」という話だった。その後Route 53のジオルーティング機能を使って地理的に近いゲームサーバー優先へ流す設定になったとのこと。ただ、この辺りTTLとかレコード種別(A・AAAA・CNAMEなど)、DNS伝播時間など色々考慮点は多そうだ。「スプリットホライズンDNS」みたいな特殊用途にも触れていた気がする。

ネットワーク監視は現場によって方法論ばらつきありそうだけど、大体PrometheusとかGrafanaあたりでメトリクス可視化しながらELKスタック(Elasticsearch, Logstash, Kibana)使う例、多かった印象。他にも分散トレーシング用としてJaegerやZipkin、パケットキャプチャにはtcpdump/wireshark等々…金融系企業ではトランザクション処理システムで断続的なタイムアウト問題に悩んだ事例もあったという。ただ負荷との直接関連性は見えず再現困難だったようだ。しかし最終的には分散トレーシング導入によって、とあるマイクロサービス内API呼び出し部分―具体的には外部連携API―が時折ハングアップしていることまで追跡できたそう。その後、一応タイムアウト値調整など対策を講じて落ち着いたという話だった気がするけれど、本当にそれですべて解決したかどうかまでは…。

Kubernetesネットワーキングでよくハマる4つの落とし穴

回路ブレーカーを導入して、連鎖的な障害をある程度防ごうとする話、あとサードパーティの依存先の状態をざっくり見られるダッシュボード作り。まあこのあたりはよく聞くけど、ネットワークの問題が起きた時って、本当にやること多い。全部に効く万能薬は見当たらないので、結局一歩ずつ確認することになる。

まず何かトラブルが発生したら、どれくらい広がっているか探るところから始まる場合が多い。なんとなく全員困ってるわけじゃなく、一部だけ影響を受けていることも珍しくないし、サービスによって違ったりもするみたい。このへん曖昧で、「全体?それとも局所的?」とか考える。

基礎的なところに戻ってみると、接続できてるかどうかとかDNSが正しく動いてそうか、とりあえずルーティングの設定もチラッと見直す。それだけで解決する時もあるから油断できない。

ログやメトリクスを見る段になると、何かしら不思議なパターンや怪しい動きを探す感じ。でも大半は地味な作業になりがちで…。pingとかtraceroute、それにtelnetまで使って通信テスト。一度や二度ならいいけど、何度もやる羽目になることもしばしば。

もし状況が読みきれなかったらパケットキャプチャまで進む人もいるだろうね。tcpdumpだったかな?Wiresharkというツール名も耳にしたことある。ここまで来たらもう細かいデータ解析の世界で、大抵原因特定にはそれなりに時間がかかる印象。

「変数をひとつずつ変えて原因切り分け」みたいなのは理屈では簡単なんだけど実際には結構根気勝負だった覚えがある。その都度メモしておけば後々役立つ…とは分かっていても忘れちゃう人も少なくないと思う。

具体例として聞いた話――あるEC系のDevOpsチームで、一時的に決済処理サービスへの接続タイムアウトが出ていたそう。支払処理そのものじゃなく、その裏側の内部プロセッサとの疎通で引っ掛かったようだった。「Connection timed out」と書いてあったけど、不定期で規則性はほぼ無かったとか。よくありがちな悩み方だ。

最初に全部のインスタンスがおかしい?と調べた結果、一部のアベイラビリティゾーン(AZ)内だけ現象発生していたという点が面白い。他では普通に動いていたという噂。

次はpingやtelnetなど基本コマンドで支払い用サーバへの到達性をチェックしてみた様子。「普通につながりますよ」と返されたので大規模障害ではない、と分かったらしい。ただ、それでも何故タイムアウトするケースが残ったままだったので妙な雰囲気になったとか。

その後ネットワーク系統の指標を調べ直す流れになったようだ。その辺りでタイムアウト発生タイミングとリンクして通信遅延(レイテンシ)が跳ね上がっている場面に気づいた……記憶違いならごめんなさい。

さらにtcpdump使って通信内容キャプチャした結果、「TCP再送信」だとか「最終的にはタイムアウト」という挙動まで観察できてしまった様子。しかしその時点では根本原因までは辿れていなかったそうだ。

最後の方でネットワーク設定自体を再確認すると、ごく最近追加されたセキュリティグループ(アクセス制御)の変更によって同時接続数自体に上限制限されていた――そんな感じだったと思う。そこを手直しして許可範囲拡張したことで事態は落ち着いたとの話。ただ、その際アプリケーションにもコネクションプーリング(つまり接続管理)機能加えたようなので複合的効果だった可能性も否定できないかなぁ、と感じた。

対策後は念入りに様子見しながら監視画面チェックして、「今のところエラー激減」と報告された程度だったろうか。確実とは言えないものの、この順番通り丁寧に辿れば解決への糸口くらいにはなるんじゃないかなぁ、と個人的には思う部分ありました。

情報整理せず散漫になっちゃったけど……こういう地味な手順踏んだからこそ隠れていた設定ミスにも気付けたわけだし、大げさじゃなく経験値上げには役立つ流れとも言える。ただ万能とは限らず、その都度地道さ優先になる場面、多めですね。

さて――マイクロサービス界隈では従来型ネットワーク管理だけじゃカバーしきれないケース増えてきてる印象です。

Dockerコンテナ間通信の問題を解決するスマートな方法

サービスメッシュという仕組みがある。いわゆるマイクロサービス同士の通信を管理するための専用レイヤーっていうやつ。とあるメディア配信系の会社で、観測性やセキュリティ、通信制御なんかを全体で揃えようとしたら、なかなか上手くまとまらなかった話があったんだよね。どのサービスも独自にサーキットブレーカーとかリトライ処理、それからモニタリングの仕組みを入れてて、バラバラだったし、保守も結構ややこしかった、と聞いたことがある。

そこでIstioを導入してみたらしい。まあ、これでだいたい次のような機能が使えるようになったとか。細かいトラフィック制御(A/Bテストっぽいものや段階的リリース)、それにmTLSによる暗号化通信、自動で取れる詳細なメトリクスやログ・トレースなどなど。ただ、この導入にはKubernetes環境にサイドカー(要は横につける小さいコンテナ)を追加する必要があって、その辺ちょっと面倒だった記憶も残っている。

例えばこんなYAMLを書くことになる。「sidecar.istio.io/inject」っていう注釈を付ければサイドカーが有効になる設計だったりする。でも細かいコードは割愛するけどね。

こういう基盤を整えておくと、全部のサービスで一貫したネットワークポリシー(例えば3回くらいまでリトライするとか、1回ごとのタイムアウトは2秒程度に抑えるとか)が実装できるわけ。ただし全てアプリ本体を書き換えずに済む点は便利そうではある。

---

CDNについて考える人も多いだろう。世界中に分散されたサーバ群で利用者に近い場所からコンテンツ配信するという発想だ。遅延を減らしたり元サーバへの負荷分散にも役立つ場面が多い。

教育系プラットフォーム運営側でも類似の課題が出たことがあったそうだ。北米だけなら特別問題にならないけれど、生徒層が広がってアジア・ヨーロッパ方面からアクセスされ始めた途端、「ページ表示が遅すぎる」みたいな声が増えてきてしまったと聞いた。それでAWS CloudFrontというCDNサービスを試してみたという流れになったらしい。

CloudFront用の設定例として、一部Terraform的な記述も見た覚えはあるけど、詳細まではあまり気にしなくてもいいかもしれない。本質的には「ユーザー近くでキャッシュ」「HTTPS必須」「用途ごとキャッシュ時間調整」「世界中へ分散」という四つくらいが主要ポイント。それぞれ微調整しながら適用したところ、海外ユーザー向けサイト表示速度は明確に改善された例も報告されていた。ただ劇的とは言わない方がいい気もする。オリジンサーバへの負荷も減少傾向だった模様。

---

ネットワークセキュリティの話題になると、「ゼロトラスト」という言葉もちょくちょく出てきたりする。「社内=安全」の前提自体疑う考え方なんだよね。「社外・社内問わず全部怪しいと思え」みたいな感じと言えば分かりやすいかもしれない。

金融系企業でもこのゼロトラストモデル導入検討ケースはちらほら見受けられるようだ。在宅勤務者増加など柔軟性確保しつつセキュリティ強化したかった背景もあったとか。その時取った策としては、おおよそ次の4点。「IDベース認証」「細かなネットワーク区切り」「最小限権限だけ与える運用」「リアルタイム監視」。VPN廃止してIDプロキシ経由接続へ移行したり、Kubernetes上でPod間通信ポリシー厳密化したり、Envoy使ってmTLS対応進めたり…。ユーザー認証についてOAuth 2.0とかOpenID Connect活用事例も耳に挟んだことある。そしてPrometheusやGrafana絡めて監視基盤固める動きも一部あったようだった。

---

現場レベルではもう少し複雑さ増す場合も多々ある。例えばグローバル展開しているECプラットフォーム企業の場合、一地域だけじゃなく複数リージョンまたぐ形でAWS上へ展開せざるを得なくなるケースも出てくる。当然ながらその時々で求められるネットワーク要件にも幅が出てくる印象あり。一口には語りづらい部分……

クラウド時代の必須スキルであるVPC設計のベストプラクティス

ある企業が、たしか七十近い地域にVPCを分けて設置していた気がする。なんというか、ネットワークの孤立性みたいなものを重視したんだろう。で、それぞれのVPC同士はトランジットゲートウェイで何となく繋げていたようだった。ただ、これも全部の地域じゃなくて、多分主要なところだけ。他にもグローバルアクセラレータとかいう仕組みがあって、利用者のいる場所から一番近いリージョンへ案内する感じ。それと、データベースも各地で同期させていたらしいけど、そのやり方も結構複雑そうだった。サービス発見にはRoute 53が使われていて、どこに何があるか探しやすかったとは聞いている。

あとIPアドレス範囲については、本当に慎重に計画したっぽい。衝突とか無駄な経路増加を避けたかったんだろうね。TerraformでVPCを作る時も、コードを見るとそれぞれ違うCIDRブロックを割り当ててる。サブネットとかNAT Gateway関連の設定も細かく分けられていて、一つひとつ手間を惜しまなかった印象。

ただ、この方法のおかげで世界中どこでも大体同じネットワーク構成になったし、利用者側から見ても体感的に速いことが多かったという話。

一方、とある医療系の会社では、大きなモノリスシステムから段階的にマイクロサービスへ切り替えていたみたいだ。その移行中には色々困ったことも起きたらしい。例えば、「どうやって新旧サービス同士を見つけさせるか」とか「ユーザーから来た通信をどっち(古いシステム or 新しいマイクロサービス)へ流すべきなのか」など悩みは尽きなかった模様。それ以外にも安全性とか監視面でも課題があったそう。

対策として最初はAPI Gatewayパターンを入れておき、リクエストごとに振り分けていた気配。その後Consulというツールでサービス発見機能を実装し始めた。でもこの辺りの詳細は人によって記憶が曖昧だったりするので、「多分こうだった」という程度。一部ではEnvoyプロキシーも導入されていて、トラフィック管理やセキュリティ向上にも少し役立ったようだ。ただ完璧ではなく、不思議と設定ファイルには微調整された箇所も多かった。

観測・追跡についてはJaegerというツールを使ってリクエストの流れを見る仕組みにしていた、と後日聞いたことがある。この漸進的な移行方式なら、大規模障害などには繋がりづらくなる場面もあったようだ。

また、小売業界で決済部分だけ特別な規格(PCI DSS)への準拠が求められていた事例も耳に挟んだ。それぞれ違うセキュリティ戦略を取っていたとも言われる。ただ、その具体的内容までは覚えてないところもある。全体として見ると、一つひとつ細かな工夫や暫定対応、新旧技術の混在ぶりなど、それぞれ特徴的だった印象ばかり残っている。

ロードバランサーの設定を工夫してトラフィック爆発に備える

PCI DSSの要件に合わせて、決済システムをどう守るかという話題があった。なんとなく覚えているけれど、ネットワーク分割とか、ファイアウォールの設定強化みたいなものが順番に出てきた気がする。CDE(カード情報を扱う環境)とそれ以外をちゃんと切り離しておく、というのは昔から言われていて、VPCやサブネットで実際そういうふうに分けることも多い。ただ、そのCIDRとか細かい数字はほぼ誰も正確には覚えていないんじゃないかな。

ファイアウォールについても、本当に厳格かどうかは運用次第らしい。許可する通信だけ絞って、それ以外ほぼ遮断。とはいえ全方向禁止だと困るので、一部サービス向けにだけ開放していたようだ。「全部塞ぐ」みたいな極端な話ではなく、「数えるほどしか開いていない」くらいの表現が近そうだ。

TLS通信でデータを暗号化する話も何度か聞いた。Kubernetesなどコンテナ周りでも証明書管理やリダイレクト設定…まあ全部HTTPS前提になってきている。Let's Encrypt使うケースが増えてきた感じ?

ネットワーク監視やログ収集――これも「全部見逃さず記録」というより、「主要な活動は押さえておこう」程度だったりすることもある。fluentdやelasticsearch連携でログまとめたり。その内容や粒度までは人によって違うし、「大体把握できれば」と考えるひとも少なくない。

そのあと、トラブルシューティングのコマンド集みたいなのが並んでいたような…。pingなんて、小さいパケットでも大きめでも、とりあえず疎通確認したい時によく使われる印象。他にもtracerouteだったりiperfだったり。この辺はネットワーク触る人なら一度は試す道具。「帯域測ったり経路調べたりできるツールはいろいろ存在する」くらいの理解でも実害は出ないかもしれない。

Kubernetes絡みだとkubectl describeとかexecとかでPod内から直接curl叩いたりして状況を見る方法も紹介されていた。network-policy-viewerという可視化ツールやIstio関連コマンドの話題もちょっと挟まれていた気がするけど、この辺になると詳しい人しか使わない印象もある。

クラウド特有の監査・診断機能――AWSならVPCフローログを見る方法、Google Cloudならネットワークインテリジェンスセンター(実際どこまで活用されているか微妙)、Azureにも似たようなNetwork Watcher的な仕組みがあるらしい。それぞれCLIコマンド例っぽいものと一緒に説明されていた気配。

要するに「よくあるトラブルを手早く調べたい時」に役立つ道具セットとしてまとめられていて、「これら全部知っておけば問題ゼロ」というより「幾つか使えば大抵何とかなる」と捉える人も多そうだ。

最後あたりにDevOps目線で現場的な設計パターンという形で事例紹介っぽいものがあった。例えばマイクロサービス間通信を安全にしたい――それもアプリ自体を書き換えず何とかしたかった、というリードエンジニアさん(名前失念)が語っていたケース。その会社ではIstioなどサービスメッシュ導入してゼロトラスト思想寄りに進めた模様。ただし全面的・完璧というより「必要最低限」「重要部分優先」が中心だったらしい。

ポッド同士の通信制御にはKubernetes NetworkPolicyを当てたり、一部だけアクセス可能にした構成。「このアプリからこのサービスへだけOK、それ以外NG」みたいな指定だったと思う。でも全体像として緻密すぎず、大まかなルール運用になっている場合も珍しくないと言われたり…。

証明書・機密情報管理にはVaultなど専用ツール使って、自動的に証明書発行・更新できるよう工夫されたケース。ただ、その設定内容まで詳細には語られておらず、おそらく「都度調整」「状況次第」くらいの温度感だったんじゃないかな。

こんなふうにセキュリティ対策や運用改善策はいろんな角度から試されていて、「一つ入れれば絶対安心」というわけではなく、複数手段を組み合わせながら妥協点探している現場が多そうだという印象ばかり残った気がする…

証明書期限切れによる大規模障害から学ぶTLS管理術

マルチクラウドのネットワーク設計、最近よく話題に上がるみたいですね。たとえばメディア配信の会社が複数のクラウドを使い分けて、コストとか障害時のリスク分散を工夫していた事例…聞いたことあるかもしれません。どこかでConsulっていうサービスディスカバリーツール使って「どこのクラウドでもサービス見つけられる」みたいな構成にしてたようです。細かい設定は置いておいて、「content-api」とか名前付けて、そのヘルスチェックも何だか毎十秒ぐらいで確認する感じだったかな。

別の日には入り口一つに見せるため、グローバルロードバランサーでトラフィック振り分けてた、と誰かが言ってましたね。Kubernetesっぽいyamlファイルでサービスを束ねて…ポートはHTTPとHTTPSだけ用意してたような気がします。それぞれタグやセレクタも適当に。

セキュリティ方針についても、どこのクラウドでも同じになるようOpen Policy Agent(OPA)という仕組みを入れていたとか。「Podは基本的にrootじゃなく動かすべき」みたいな規則を書いてコンフィグマップとして管理していたと聞きました。でも、現場によって書き方や運用方法も微妙に違うので、一概には言えません。

結果として、その会社では色んなところで同じ感覚でワークロードを回せるし、ネットワークやセキュリティ、それから監視なんかも似通った仕組みにできたそうです。ただ細部は実際触ってみないとわからないことも多いものです。

もう一つ思い出した話ですが…IoT関連のプラットフォームでは「データは出来るだけ近く(エッジ側)で処理したい」と考えているところが増えている印象があります。その場合、小さめのKubernetesクラスターを各地にばら撒いて、「edge-processor」みたいなアプリケーションをざっくり二台ぐらいずつ展開していました。それぞれedgeノード向けに配置指定しちゃう感じです。CPUやメモリ割当てもだいたい控えめだったと思います。

あと、エッジ同士直接やり取りできるようなmeshネットワークもよく話題になりますね。「*.edge.local」みたいな内部DNS名へのServiceEntry作ってたり。でも設定細部まで厳密には統一されてない場合も多そうです。

データ同期どうする問題にも色々解決策があります。Kafkaなどメッセージキュー経由なら中央との通信が不安定でも多少耐えられるんですよね。「kafka.central:9092」に繋げばOKという単純さ。ただプロパティ類はいろんな値試行錯誤していた様子でした。

こんな具合なので、「現地優先処理+中央集約」スタイルは低遅延志向にはそこそこ効果あると言われています。ただ万能とは限りません。

少し話変わりますが――DevOps界隈では今後のネットワーキング事情について予想混じりによく語られます。まず「ネットワーク自体コード化する流れ」、これは数年前から加速中でしょうね。「AWS CDK」の例だとJavaScript混じりですが、結局VPC作ったりサブネット切ったり…三種類くらい区画分けたりしますよ、と書くだけなんです。でも、この手法にもまだ課題残っていますし全員賛成というわけではありません。

それからeBPF活用した可観測性アップにも期待寄せる声あります。有名なのはCiliumですが、「web-service」というラベル付与されたエンドポイント監視しつつ、「frontend」から来るHTTP GETだけ許可するとかそういう設定を書くらしいです。またDB接続部分だけ出口制御したり。一応YAMLベースなので柔軟性高そうですが、本当に全部管理できているケースは案外少ないとも耳にします。

5Gとエッジ計算資源との組合わせにも注目する人ちらほらいますね。「AWS Wavelength」を使うならリージョン選択後、ご当地専用ゾーンへサブネット作成、とまあそんな手順になっています。VPC名やインスタンスイメージあたり忘れやすかった記憶…。

AIOps――つまりAI活用運用についてもちょっとずつ進展ありそうです。「Prometheus」「Grafana」で異常検知アラート出す例など知られてますが、「95パーセンタイル遅延」が平常時より大幅上昇すると警告飛ぶ式ですね。ただ閾値調整難しくて上手く働かない日もあるとか。一部ユーザーしか恩恵受けてない印象の日もあります。

最後になりますが――ネットワーク知識って今どきDevOps担当者には無視できない領域になっていますね。IPアドレスやルーティングなんて当たり前、その先のサービスメッシュ・ゼロトラストまで把握する必要ある場面増えています。有名なSarahさん?彼女の場合マイクロサービス間通信トラブルで苦労してましたが、一層一層原因潰して解決に近づいたと言われています。その経験以降は「開発段階から必ずネットワーク要素考慮するようになった」と伝え聞いています。このあたり、人によって状況異なるでしょうけど──ここまで紹介されてきたツール群・設計パターン類もうまく組合わせれば、多層的なチャレンジにも対応できそうです。ただし万能策とは言い切れません。不確実性込みで道具箱増やすイメージでしょうか…。

サービスメッシュ導入でマイクロサービスの通信問題を一掃する

ネットワークって、ただ繋がるだけじゃないみたいだね。セキュリティとかパフォーマンスとか、なんとなく柔軟性や伸びしろ――ああ、規模の話かな――もすごく大事になる場面がちらほらある。どうやらシステムを設計するときって、その時々で変わる要件や思いもよらないトラブルにも何となく対応できる構えが求められるっぽい。

これから先、ネットワーク技術は徐々にソフトウェア寄りになったり、自動化とか賢さを増していくらしい。だから好奇心を持ち続けて、学ぶことをやめず、「なんでこうなるんだろう?」と考えながら一歩ずつ積み重ねていく人が、たぶんDevOps界隈でも頼りにされやすいのかもしれない。

最初の方で登場したサラさん――覚えてる?あの人はマイクロサービス絡みの問題を何とかした半年後ぐらいには、チーム内でネットワーク系の質問が集まるような存在になっていたという話も聞いた気がする。必要に迫られて始めた分野が、いつの間にか得意分野になってキャリアアップにもつながった…そういう流れ、珍しくないかもしれない。同じようなチャンスは他の誰にも巡って来る可能性もありそうだし。

深夜三時頃に本番環境で何か障害っぽいものと格闘する場合でも、大規模な新しい仕組みを考える場面でも、このガイドから得た基礎的な知識はたいてい役立つと思われる。積極的に手を動かして慣れておけばいいし、新しく知ったことは周囲と共有したりメモ残しておけば、そのうち誰かの助けになることもありそう。

結局ネットワークというものは単なる機械同士じゃなく、人だったりアイディアだったり、それぞれ別々のパーツをつなぎ合わせて想像以上に大きなシステムへ発展させていく部分なのかな――そんなふうにも感じたり。

トラブルシュートするときには、一番簡単な確認作業から地道に積み上げて調べて行く方が後々混乱しづらかった印象ある。メモ取っとけば「あれ前どうやったっけ」って時にも助かった記憶もちょっとある。

さて…もう少し詳しく知りたい場合には、それ用の本とかコースとかツールも色々あるよ。「Network Programmability and Automation」と呼ばれている書籍(著者名までぱっと出てこないけど)、それから「Kubernetes Networking」だったかな。他にも「Zero Trust Networks」関連も目についたことある。

オンライン講座としてはAWS公式サイトで提供されているものだったり、有名どころだとCiscoやGoogle Cloud関連でも応用編っぽい内容見かけた気がする。「Advanced Networking on AWS」とか、「Google Cloud Professional Cloud Network Engineer」なんちゃら…。

ツールについて言えばIstio(サービスメッシュ系)、Cilium(eBPF使ったやつ)、Consul(サービスディスカバリ用途)、Terraform(インフラ管理)など挙げればキリないぐらい。全部触れる必要までは感じないものの、自分に合う範囲だけでも慣れておけば損は無さそう。

コミュニティならSlack経由で参加できるグループとか、「Kubernetes Network SIG」という専門家達が集まる集まり、それと「DevOps Networking Forum」みたいな場所もちらほら耳に入る。

こういう勉強会や情報交換含め、ときどき新しい視点取り入れてみたりすれば、自分自身だけじゃなくチーム全体への貢献度もちょっとずつ上げていけそうだよね。高性能・高信頼性・拡張性…まあ、その全てとは言わずとも今より良くしていきたいならネットワーク領域への理解深めといて損は無さそう。その土台から色んなアイディア湧いてくれば、思わぬチャレンジにも対応できたり、新しい工夫試せたりする余地も生まれるんじゃないかな……多分。

これから先、ネットワーク技術は徐々にソフトウェア寄りになったり、自動化とか賢さを増していくらしい。だから好奇心を持ち続けて、学ぶことをやめず、「なんでこうなるんだろう?」と考えながら一歩ずつ積み重ねていく人が、たぶんDevOps界隈でも頼りにされやすいのかもしれない。

最初の方で登場したサラさん――覚えてる?あの人はマイクロサービス絡みの問題を何とかした半年後ぐらいには、チーム内でネットワーク系の質問が集まるような存在になっていたという話も聞いた気がする。必要に迫られて始めた分野が、いつの間にか得意分野になってキャリアアップにもつながった…そういう流れ、珍しくないかもしれない。同じようなチャンスは他の誰にも巡って来る可能性もありそうだし。

深夜三時頃に本番環境で何か障害っぽいものと格闘する場合でも、大規模な新しい仕組みを考える場面でも、このガイドから得た基礎的な知識はたいてい役立つと思われる。積極的に手を動かして慣れておけばいいし、新しく知ったことは周囲と共有したりメモ残しておけば、そのうち誰かの助けになることもありそう。

結局ネットワークというものは単なる機械同士じゃなく、人だったりアイディアだったり、それぞれ別々のパーツをつなぎ合わせて想像以上に大きなシステムへ発展させていく部分なのかな――そんなふうにも感じたり。

トラブルシュートするときには、一番簡単な確認作業から地道に積み上げて調べて行く方が後々混乱しづらかった印象ある。メモ取っとけば「あれ前どうやったっけ」って時にも助かった記憶もちょっとある。

さて…もう少し詳しく知りたい場合には、それ用の本とかコースとかツールも色々あるよ。「Network Programmability and Automation」と呼ばれている書籍(著者名までぱっと出てこないけど)、それから「Kubernetes Networking」だったかな。他にも「Zero Trust Networks」関連も目についたことある。

オンライン講座としてはAWS公式サイトで提供されているものだったり、有名どころだとCiscoやGoogle Cloud関連でも応用編っぽい内容見かけた気がする。「Advanced Networking on AWS」とか、「Google Cloud Professional Cloud Network Engineer」なんちゃら…。

ツールについて言えばIstio(サービスメッシュ系)、Cilium(eBPF使ったやつ)、Consul(サービスディスカバリ用途)、Terraform(インフラ管理)など挙げればキリないぐらい。全部触れる必要までは感じないものの、自分に合う範囲だけでも慣れておけば損は無さそう。

コミュニティならSlack経由で参加できるグループとか、「Kubernetes Network SIG」という専門家達が集まる集まり、それと「DevOps Networking Forum」みたいな場所もちらほら耳に入る。

こういう勉強会や情報交換含め、ときどき新しい視点取り入れてみたりすれば、自分自身だけじゃなくチーム全体への貢献度もちょっとずつ上げていけそうだよね。高性能・高信頼性・拡張性…まあ、その全てとは言わずとも今より良くしていきたいならネットワーク領域への理解深めといて損は無さそう。その土台から色んなアイディア湧いてくれば、思わぬチャレンジにも対応できたり、新しい工夫試せたりする余地も生まれるんじゃないかな……多分。