AIの偏見って、結局は僕らを映す鏡だったのかもしれない

最近考えてたんだけど、生成AIってあるじゃないですか。プロンプトを入れると、文章とか絵とかを勝手に作ってくれるやつ。あれって、本当に「新しいもの」を生み出してるのかなって。

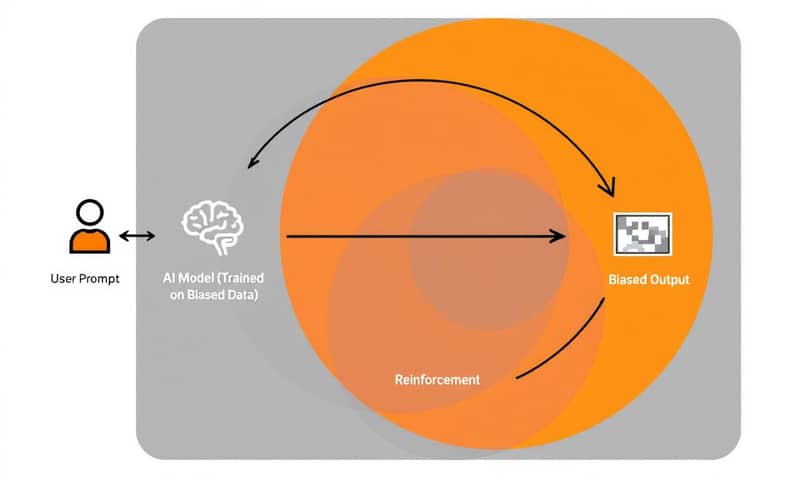

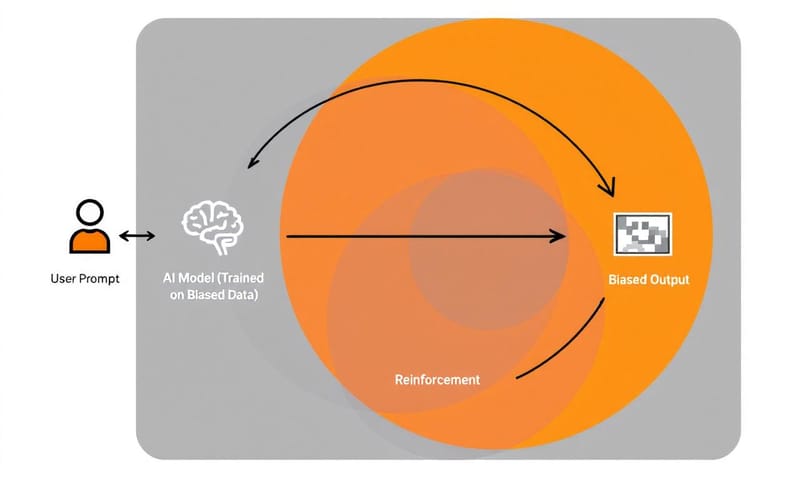

もしかしたら、ただ僕たちの社会が持ってる偏見とか、見えない偏りを、新しい形で増幅してるだけなんじゃないか、と。

正直、AIが賢くなればなるほど、その出力結果は、僕らがネットに垂れ流してきた言葉や画像の、ただのこだまに聞こえることがある。…うん、そういうことなんだと思う。

重点一句話

AIのバイアス問題って、AIを直すだけじゃダメで、AIに指示を出してる僕たち自身の「無意識の偏り」に向き合わないと、永遠に解決しないんだよね。

「優秀なエンジニア」を募集したら、元軍人ばかり推薦してきたAI

これ、笑えない話なんだけど。とある金融機関が、自社で開発した文章生成AIのストレステストをした時のこと。

「シニアエンジニア職」の募集メールを書かせてみたら、AIが提案してきた応募条件がすごかった。「屈強な軍役経験」とか「戦闘地域での決断力のあるリーダーシップ」とか…。いや、エンジニア募集してるんだよね?

これって、AIが学習したデータの中に、「リーダーシップ」とか「シニア」っていう言葉と、「男性」や「軍隊」みたいな単語が強く結びついちゃってたからなんだ。結果的に、女性や軍歴のない人は、最初から「不適格」って弾かれちゃうような文章ができてしまった。

面白いのは、そのあと。研究チームが、女性が書いたリーダーシップ論とか、女性が活躍してる企業の事例とかを、意図的にAIの学習データに追加したんだ。そうしたら、AIが提案する文章が、やっと多様性のあるものに変わっていったらしい。

…つまり、ほっとくと、AIは一番声の大きい意見、つまり社会の多数派の意見をどんどん真似して、増幅させちゃうってこと。静かな声は、どんどん聞こえなくなっていく。

じゃあ、どうすればいいの?

専門家たちがやってるのは、だいたい二つの方向性がある。一つは、AIの「外側」、つまり僕たちが入力するプロンプト自体から偏りをなくそう、っていうアプローチ。

もう一つは、AIの「内側」、つまりモデルの学習プロセスそのものに手を入れて、偏見が生まれる前にそれを摘み取っちゃおう、っていう考え方。

- 学習データの多様化:これは基本だよね。英語圏だけじゃなく、いろんな言語のデータを入れたり、これまであまり光が当たってこなかったコミュニティの文章や画像を積極的に学習させる。一つの価値観が支配的になるのを防ぐ感じ。

- プロンプトの監査ツール:ユーザーが入力した言葉をリアルタイムで分析して、「その言葉、ちょっと偏ったイメージを助長するかもですよ」って教えてくれるツール。より中立的な表現に導いてくれる。

- 敵対的デバイアス(Adversarial De-biasing):これ、面白いんだよ。AIを二つ用意して、片方のAI(探偵役)が、もう片方のAI(本体)が生み出す文章や画像から「ステレオタイプな表現」を見つけ出そうとする。本体のAIは、探偵役のAIにバレないように、偏見を消していくことを学習する。…AI同士で、間違い探しをさせるみたいなもんだね。

もっと仕組み化しない? 「COGNIS」っていう考え方

でもね、こういう技術的な対策って、どうしても場当たり的になりがち。そこで、倫理学者とか技術者たちが集まって「COGNIS」っていう統合プラットフォームの構想を提唱してる。

これは、もっとちゃんと、AI開発の全プロセスでバイアスをチェックする仕組みを作ろうぜ、っていう話。場当たり的な修正じゃなくて、ちゃんとルール化された規律にしよう、と。

これまでのやり方と、COGNISが目指す世界を比べてみると、こんな感じかな。

| 評価項目 | これまでのやり方(場当たり的) | COGNISが目指すやり方(仕組み化) |

|---|---|---|

| タイミング | 問題が起きてから。「炎上したから直そう」みたいな。完全に後手後手。 | 最初から最後まで。データセットの段階から、公開後のモニタリングまで、全部。 |

| 透明性 | だいたい非公開。企業秘密ってやつ?中で何やってるか全然わかんない。 | 監査ログを全部公開する。誰でもチェックできるようにして、透明性を確保する。 |

| 評価者 | 開発チームだけ。身内でチェックしても、甘くなりがちだよね…。 | 大学、市民団体、いろんな分野の専門家とか、第三者が入ってチェックする。 |

| ゴール | とりあえず「動く」こと。パフォーマンス優先。バイアスは二の次。 | 「公平性」もパフォーマンスの指標の一つ。偏りのあるモデルはリリースしない。 |

こうやって見ると、全然違うよね。単なる技術の話じゃなくて、AI開発の文化そのものを変えようとしてるのがわかる。

でも、技術だけじゃ絶対無理な話

そう。COGNISみたいな立派な仕組みを作っても、それだけじゃ足りない。結局は、それを使う「人」と「文化」が変わらないと意味がないんだ。

エンジニアはただコードを書くだけじゃなくて、倫理的な側面を常に問い続ける姿勢が必要になるし、経営者は「独自技術だから」って情報を隠すのをやめなきゃいけない。で、僕たちユーザーも、AIが生成したものを「はい、そうですか」って鵜呑みにするんじゃなくて、「これ、本当に中立なのかな?」って疑う視点を持つことが大事。

そういえば、こういうAI倫理の考え方も、国によってちょっと温度差がある気がする。例えば、アメリカのNIST(米国国立標準技術研究所)が出してる「AIリスクマネジメントフレームワーク」は、すごく実践的で、企業がどうリスクを管理するかっていう視点が強い。ビジネス寄りの発想だね。

一方で、日本の総務省が出している「AI開発ガイドライン」なんかを読むと、「人間中心の原則」とか「社会原則」みたいな言葉が出てきて、技術がどう社会に受け入れられるか、調和するかっていう視点を大事にしているように感じる。どっちが良いとか悪いとかじゃなくて、この違いを分かっておくのは、結構重要かも。

【審核清單】あなたのAI、世に出す前に

最後に、もし自分がAIを使ったサービスを作ることになったら、自問自答すべきことをリストアップしてみた。まあ、自分用のメモみたいなもんだけど。

- □ そのAIの学習データ、偏ってない? 特定のグループや文化の声ばかり拾ってない?

- □ ユーザーに「中立的なプロンプト」の書き方をちゃんとガイドしてる?

- □ バイアスを検出するための、第三者による定期的なチェック体制はある?

- □ AIが出した「おかしな結果」を、ユーザーが簡単にフィードバックできる窓口はある?

- □ 開発チームのメンバー構成は多様? 同じような背景の人ばかりで作ってない?

- □ 利益や効率のために、意図的に「公平性」を犠牲にしている部分はない? 正直に。

…うん。結局、AIは道具でしかない。その道具が、僕たちの過去の過ちを繰り返すだけの拡声器になるか、それとも僕たちが目指したい未来を一緒に作ってくれるパートナーになるか。それは、僕たちがどういう問いを立てて、どういう仕組みを作って、どういう文化を育てるかにかかってるんだと思う。道は…長そうだけどね。

あなたはどう思いますか?

生成AIを使っていて「あれ?」って思うような、偏った結果が出た経験はありますか? よかったら、どんなプロンプトでどんな結果が出たか、コメントで教えてください。なぜそうなったのか、みんなで考えてみるのも面白いかもしれません。