嗯…先說個大概,數字不是全部

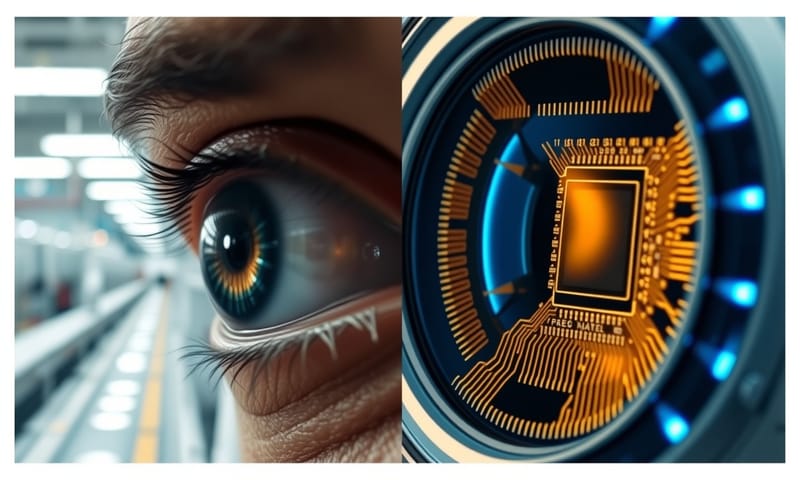

很多人在問,機器視覺…就是那個用 AI 去做品檢的,跟傳統用人眼睛去看,準確度到底差多少。嗯…這個問題,說實話,沒有一個標準答案。你看一些報告或文章,可能會丟給你一個數字,說機器準確率 99% 以上,人工大概 70% 到 85% 左右。 聽起來差很多,對吧?

但…事情不是這麼簡單。這個數字,比較像是在一個…很完美的實驗室環境下跑出來的。機器做的,是它被「教」會要找的特定瑕疵,而且它不會累、不會分心,所以重複性很高。 人呢,會累、會晃神,心情不好可能標準也不一樣了,所以良率會飄。 這點是事實。

不過,我自己在看的感覺是,重點不在那個…嗯…最終的百分比。真正的差別,在於「犯的錯誤類型」不一樣。機器很會抓那種很微小、很固定的問題,但對於它沒學過的、從來沒看過的「新瑕疵」,它可能就直接忽略了。 人就不一樣,人有…一種直覺吧,有時候看到一個說不出來哪裡怪怪的東西,反而能揪出大問題。所以,這不是一個誰取代誰的問題,更像是…嗯,怎麼合作。

所以,機器真的有看得比較準嗎?

如果我們把「準」這件事拆開來看…可以分成幾個面向。效率上,那沒話說,機器肯定是輾壓。一條產線,特別是那種高速運轉的,機器一分鐘看幾百甚至上千個,人根本不可能。 這是量的勝利。

再來是精度。人眼有物理極限,太小的東西,就算拿放大鏡看,看久了也會花。 機器可以用更高解析度的相機,去抓那種…嗯…微米等級的細節,這點人也比不上。 像是一些半導體或面板業,很多瑕疵是人眼根本看不見的,那就必須靠機器。

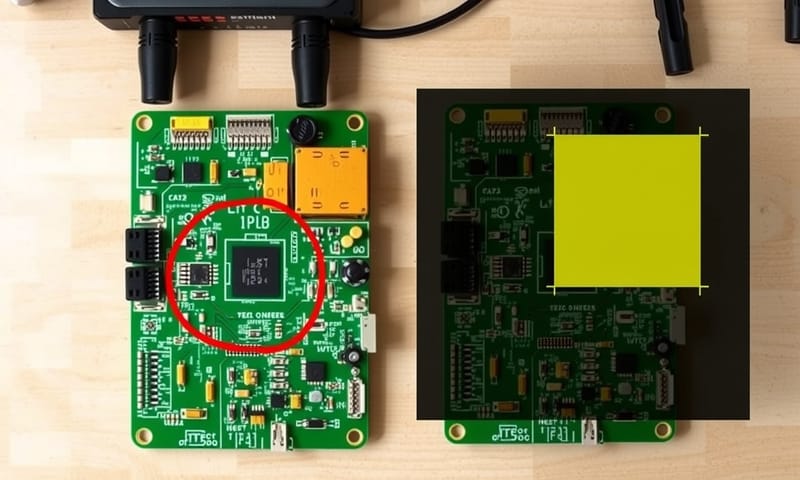

可是,談到「漏判」跟「誤判」,情況就複雜了。傳統的 AOI,也就是自動光學檢測,它比較死板。你用程式規則(Rule-based)告訴它,長度超過 5mm、顏色比色票深 10% 就是不良品。 為了不漏掉任何一個可能的瑕疵,工程師通常會把這個規則設得…非常嚴格。 結果就是,很多其實沒問題的「良品」,因為一點點微小的差異,也被當成壞的,這就是「誤殺」。

AI 進來之後,情況好一點。它不是靠寫死的規則,而是靠「學習」。你給它看幾千幾萬張照片,告訴它這個是好的、那個是壞的,它會自己…嗯…歸納出一個判斷模型。 這種方式對於那種長得不規則、每次都不太一樣的瑕疵,比如刮痕、髒污,就比傳統 AOI 強很多。 不過,這就引出下一個問題了。

AI 是怎麼…嗯…怎麼學會「看」的?

這個學習過程,其實…說穿了,就是大量的「人工」。對,你沒聽錯,AI 的背後是滿滿的…「工人智慧」。 在 AI 開始學習之前,需要有人先把成千上萬張的樣本圖片一張一張地標出來,這個叫「標註」(Labeling)。 比如,要教 AI 認識晶圓上的刮痕,就要有人拿著滑鼠,把每一張圖片裡的每一條刮痕,都框起來,然後告訴 AI「這就是刮痕」。

這個過程,非常…非常花時間。有分析說,整個 AI 專案裡,大概有 80% 的時間都是在處理這些資料、標註資料。 而且標註的品質,直接決定了 AI 學得好不好。如果一開始人就標錯了,那 AI 就學到錯的東西,這叫 Garbage in, garbage out。

所以,AI 的優勢在於,一旦它學會了,就可以…嗯…非常快速地複製這個能力,而且不會累。 它可以 24 小時一直看。 但它的弱點也很明顯,就是前期需要投入非常高的成本,包括硬體…像是需要好的 GPU 卡去跑運算,還有…就是剛剛說的,大量的人力跟時間去做資料標註。

這也解釋了為什麼 AI 檢測沒辦法馬上導入就用。就算是在相似的產線,換了個新產品,AI 還是需要重新收集資料、重新訓練。 它不像人,可以觸類旁通。它只懂你教過它的事。

那什麼時候,人還是比機器強?

說了這麼多機器的優點,但…嗯…在某些地方,人還是無法被取代的。最重要的一點,就是「脈絡判斷」和「常識」。 機器看到的是像素,是數據。人看到的是一個…有前後文的產品。

比方說,一個瑕疵,如果出現在產品不明顯的背面,經驗老到的師傅可能會判斷這是可接受的。但對機器來說,只要特徵符合,它就判定為不良。AI 檢測雖然可以設定「容錯空間」,但這種判斷還是…比較僵化。

另外一種情況是「少量多樣」的生產。 如果產線一天到晚在換產品,每種產品的量都不大,那根本沒有足夠的瑕疵樣本去訓練一個 AI 模型。 在這種情況下,傳統 AOI 或是直接用人工檢測,反而…嗯…更有效率、成本更低。

還有就是,當需要檢測的不是「瑕疵」,而是像長度、直徑這種「量測」工作時,AI 其實…沒有比傳統的演算法來得好。 傳統的 Rule-based 方法反而更穩定精確。

我看到一份美國那邊的資料,談到在營建業的品管,他們覺得 AI 很適合做重複性的監控,像是看鋼筋有沒有綁好、有沒有裂縫。 但最終要判斷這個建築合不合乎法規、安不安全,還是要靠有執照的檢查員。 這點跟台灣的狀況有點像,像是工業技術研究院(ITRI)他們也在推智慧製造,但很多時候 AI 是作為輔助工具,最後拍板的…還是人。

| 比較項目 | 機器視覺 (特別是 AI) | 人工檢測 |

|---|---|---|

| 準確度 / 一致性 | 教對了就很穩,數字可以很高看,但有點…死腦筋。 | 會累會分心,標準會飄,但有時會有神來一筆的直覺。 |

| 速度 | 沒得比,快非常多,尤其是在生產線上。 | 就是…人的速度,固定就那樣,快不起來。 |

| 拿手項目 | 抓那種很小、重複出現的瑕疵。還有,它不睡覺。 | 判斷沒見過的怪問題、需要彈性思考的狀況。 |

| 弱點 | 前期要花很多時間跟人力去教它(標註資料),沒教過的就不會。 | 會疲勞、會受情緒影響,而且…嗯…人力成本越來越高。 |

| 導入成本 | 一開始很貴,要買硬體、要花時間訓練。但長期來看可能划算。 | 初期好像便宜,但薪水要一直付,是持續的開銷。 |

釐清一些常見的…嗯…誤解

最後想聊聊幾個大家常搞混的點。

第一個是,以為 AI 導入了,就不需要人了。恰恰相反,是需要「另一種人」。你需要懂資料、懂標註、懂訓練模型的工程師。 原本的產線老師傅也非常重要,因為只有他們才知道,哪些瑕疵是「真的有問題」的,這些經驗…需要被傳承給 AI,嗯…應該說是傳承給訓練 AI 的人。

第二個迷思是,覺得 AI 什麼都能檢測。不是的。AI 特別適合處理那種…「很難用規則去定義」的瑕疵。 如果一個問題,用很簡單的長寬高就能判斷,那用傳統的 AOI 就好,便宜又有效,殺雞不用牛刀。

再來就是,很多人會把機器視覺跟…嗯…比如光達(LiDAR)那種技術搞混。機器視覺主要是用攝影機「看」影像,做 2D 的分析比較多。 光達那些是發射雷射去建立 3D 的空間模型,比較常用在自動駕駛或機器人導航。 雖然都是感測,但技術路徑跟應用場景…差很多。

總結來說,機器視覺跟人工檢測,真的不是誰比較「準」這麼簡單的二分法。它們各自有擅長的舞台。我覺得,未來最好的方式,應該是讓機器去做那些重複性高、累死人的基礎篩檢,然後把省下來的人力,去做…嗯…更有價值的、需要思考和判斷的複檢工作。這樣,可能才是比較…健康的發展方向吧。

聊聊你的看法

在你自己的工作領域中,你覺得有哪個檢測或品管的環節,是 AI 短期內絕對無法取代人力的?在下面留言分享一下你的想法吧。