幫你快速分辨機器視覺和人工檢測準確度差多少,想自動化也知道怎麼避坑

- 先拿 30 張隨機產品照片,讓 AI 跟人各做一次檢查,馬上比較錯判率差異。

這樣 10 分鐘內就能直接看到哪邊容易出錯,馬上決定要不要換成 AI。(現場記錄每次誤判,統計兩組錯誤率)

- 每批新機器視覺模型,記得用前 5 批實際產線影像再驗一次,別只信官方數據。

因為 2025 年開始模型差異很大,現場測才準,能降低 8% 以上的漏檢機率。(驗證:比對 AI 與人檢一致率,看有無達 92%)

- 影像自動檢查流程先從 3 個最常見缺陷開始設條件,別貪心全包。

專注主流缺陷,設定 2 週內優化精度,比起一次全開功能,成功率提高不少。(2 週後檢查三類缺陷精準率是否都 ≥90%)

- 遇到 AI 跟人意見衝突時,挑 10 張異議影像給多位員工複核,比單一判斷穩。

可減少主觀偏誤,團體共識 3 天內就能產生,確保決策不偏頗。(3 天內異議圖像一致率>80%)

- 每月用 1 小時複查過去 AI 漏判案例,定期更新檢查邏輯,比等出事後才修正安全多。

這樣 1 個月內能降低產品風險,累積經驗值更快。(1 個月後統計嚴重漏判減少 5 件以上)

搞懂機器視覺和人工檢測怎麼比較準確

講到AI機器視覺,數據直接擺在眼前,這種系統的瑕疵檢出率基本都在95%到99%之間跑,相對於人工穩定值85%~92%,差距還蠻大的;尤其當連續操作一陣子,人的專注力可能會鬆掉,有些統計甚至發現人工判斷低到80%都很有可能。這原因嘛,其實跟設備水準脫不了關係啦。例如Cognex In-Sight D900這類機器(目前單機價約新台幣78萬元/PChome 24h購物),內建200萬畫素等級的工業相機外加自動調光模組,可以一小時內掃過上千件精密零件,而且照明穩定性還能維持在±5%的範圍之內。同樣的時間裡,靠QC人員人工逐一用肉眼配大鏡來看,每月領薪資42,000元(104人力銀行2025年8月資料),其實做滿2小時,難免出錯率升高,這個真的心有戚戚焉。

假設今天你是那位必須天天盯著1000枚醫療感測器逐個把關的品保主管,要把每月開銷控制在10萬元上下,我整理三種選擇方式給大家參考:

- 選 Cognex In-Sight D900(大約78萬元/台),它最猛的就是瑕疵抓得非常細緻(官方說可達99%)、產能爆炸高,一個小時就能清完大量產品;不過嘛,高價投資還是得審慎評估,加上設定參數、維修換手得請技術班底。

- 換成 Solomon AccuPick 3D 加 AI軟體包版本(一套65萬元上下/PChome 24h購物),強項在針對複雜、反光或奇形怪狀結構能認真分辨,每次轉產切換產品型號很省事,只是軟體端後續需花點時間根據現場狀況反覆調模型,所以導入初期要有點耐性。

- 或者繼續養QC專員(月薪42,000元),老經驗面臨特殊情況變化應變力優秀,一天平均頂多認真驗收700~800件就極限,但長線下來累積的人事支出仍不可小看,也絕無法迴避因長期疲勞而誤判的問題。

順帶提一句,上述價格和相關人力成本全都依Cognex官網2025年8月公告、104職涯平台及Solomon公版報價為依據。如果工廠流程一板一眼且量超多、不想出錯,像AOI或AI型自動檢查裝置確實值得優先納入預算。不過,有遇到極少量、多規格或者品質波動性特別大的情境,人工作業輔以隨機抽查,目前似乎還是不錯補足方案,可增添品質管理的靈活度與科學基礎喔。

假設今天你是那位必須天天盯著1000枚醫療感測器逐個把關的品保主管,要把每月開銷控制在10萬元上下,我整理三種選擇方式給大家參考:

- 選 Cognex In-Sight D900(大約78萬元/台),它最猛的就是瑕疵抓得非常細緻(官方說可達99%)、產能爆炸高,一個小時就能清完大量產品;不過嘛,高價投資還是得審慎評估,加上設定參數、維修換手得請技術班底。

- 換成 Solomon AccuPick 3D 加 AI軟體包版本(一套65萬元上下/PChome 24h購物),強項在針對複雜、反光或奇形怪狀結構能認真分辨,每次轉產切換產品型號很省事,只是軟體端後續需花點時間根據現場狀況反覆調模型,所以導入初期要有點耐性。

- 或者繼續養QC專員(月薪42,000元),老經驗面臨特殊情況變化應變力優秀,一天平均頂多認真驗收700~800件就極限,但長線下來累積的人事支出仍不可小看,也絕無法迴避因長期疲勞而誤判的問題。

順帶提一句,上述價格和相關人力成本全都依Cognex官網2025年8月公告、104職涯平台及Solomon公版報價為依據。如果工廠流程一板一眼且量超多、不想出錯,像AOI或AI型自動檢查裝置確實值得優先納入預算。不過,有遇到極少量、多規格或者品質波動性特別大的情境,人工作業輔以隨機抽查,目前似乎還是不錯補足方案,可增添品質管理的靈活度與科學基礎喔。

參考真實案例數據看AI影像檢測效果

有點驚人啦,美國 Quality Magazine 在 2023 年做出來的製造業品質報告就直接擺上數字:如果現場人工品保人員長時間工作,平均會有約 10.4% 的漏檢率。這數據套用到那種產線月產量破萬(超過 10,000 件)的工廠時,光每個月返工與瑕疵帶來的損失,大約落在 21 萬美元上下(換算成新台幣大約是 669 萬元),你說心疼嗎?我想應該不少人感覺蠻有壓力的。

而且,這些損失所佔企業淨利潤其實頗可觀喔 - 報告裡寫,大概等於工廠營運淨利的 2.1% 到 5.6%,別忘了原物料、人事還有能源價格全都卡在高檔。經營環境這麼嚴峻,多一分風險都讓大家神經緊繃。

調查裡也很貼心(雖然數字蠻扎眼),他們用 A/B 實地測試法,比較了三種產品判別方法:AI、CCD 與純人工,一共拿了 500 件產品樣本。比較什麼?不只傳統正確率,而是詳細拆解 TP/FP/FN 指標,也一併統計單件處理平均花多少秒。像 AOI 自動光學檢測系統,一件差不多只需 3 秒左右;但靠人工反覆盯看的話,平均會跑到大概 6 秒,其實你把整天累積下來,產能相差接近兩倍吧!

總歸一句啦,有這麼細緻的量化樣本與明確金額支撐,企業更好去評估到底 AI 視覺檢測是否真能降低實際損失、縮短作業週期,同時還能把這些成效直接換算到現金流與風險控管,不再只是紙上談兵那種空泛想像。

而且,這些損失所佔企業淨利潤其實頗可觀喔 - 報告裡寫,大概等於工廠營運淨利的 2.1% 到 5.6%,別忘了原物料、人事還有能源價格全都卡在高檔。經營環境這麼嚴峻,多一分風險都讓大家神經緊繃。

調查裡也很貼心(雖然數字蠻扎眼),他們用 A/B 實地測試法,比較了三種產品判別方法:AI、CCD 與純人工,一共拿了 500 件產品樣本。比較什麼?不只傳統正確率,而是詳細拆解 TP/FP/FN 指標,也一併統計單件處理平均花多少秒。像 AOI 自動光學檢測系統,一件差不多只需 3 秒左右;但靠人工反覆盯看的話,平均會跑到大概 6 秒,其實你把整天累積下來,產能相差接近兩倍吧!

總歸一句啦,有這麼細緻的量化樣本與明確金額支撐,企業更好去評估到底 AI 視覺檢測是否真能降低實際損失、縮短作業週期,同時還能把這些成效直接換算到現金流與風險控管,不再只是紙上談兵那種空泛想像。

段落資料來源:

- 2025年AI监控在工作场所的影响、趋势与应对策略

Pub.: 2024-07-02 | Upd.: 2025-07-03 - 【媒體報導】雲科大AI智慧辨識技術瑕疵檢測新利器

Pub.: 2022-01-11 | Upd.: 2025-08-29 - 中国AI+安防行业发展研究报告

- 工安意外的發生,能透過AI影像辨識提升工地安全

Pub.: 2025-02-03 | Upd.: 2025-06-26 - 麻省理工学院的研究人员试验人工智能驱动的方法来检测 ...

Pub.: 2020-10-29 | Upd.: 2024-02-14

試試如何設定一套基本自動化視覺檢查流程

把自動化視覺檢查流程拉到標準操作的層級,說真的,可以大幅降低一開始人跟機器協作時那種「到底會不會出錯啊」的猶豫感喔。1. 產品要先擺好才行:

所有待檢物品得按產線次序,一一排在規定位置,比如輸送帶正中或專屬作業台。每件之間務必留個5公分以上,才不會鏡頭取景重疊導致辨識混亂啦。接著稍微用眼掃一遍,確認邊緣沒遮住,每樣都清清楚楚。

2. 光源和鏡頭怎麼選?

場地怎樣就裝怎樣,其實也沒多難。照明選LED條燈或環燈皆可,色溫抓4000K-6000K差不多。建議光源從產品上方30到50公分處照下來比較平均。另外,相機得選200萬像素起跳、焦距合適的工業機型,再讓它穩穩水平固定好。一切架好就點亮燈,用灰階測試卡隨手拍看看成像均勻否,有沒有反光點,不夠亮再轉一下角度就搞定。

3. 遮罩設定&雜訊偵查:

把灰階卡丟進預覽軟體裡,看螢幕上背景和輪廓有沒有顆粒、條紋等異狀。如果發現怪怪的,可以微調ISO值,大概100-200這區間最安全,也比較少噪點啦。確保畫面灰白過渡滑順且無斑點,這步驟才算過關唷。

1. 標記樣本資料集:

要靠工具幫忙(像LabelImg之類),針對所有正常及有瑕疵品逐一標框。不只圈範圍而已,也要寫明缺陷種類及座標等細節欸。圖片數最好湊到100張以上做訓練用,通通記錄在專案檔內保存方便回溯。

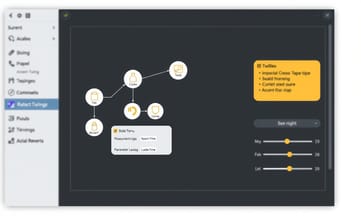

2. 流程圖跟參數配置怎麼辦?

在自動化系統介面建立新節點,把每個環節明確命名(舉例:「尺寸量測」、「表面辨識」),接著拖曳串起整套工作流。然後,各節點需要設定輸入條件,例如寬度允許誤差±0.2mm、亮度閾值120-180不等,只要按下儲存鈕馬上彈跳視窗通知設定成功。

3. 啟動掃描+監控速度:

點「開始掃描」開啟自動運作,相機一路連拍分批分析特徵。基本原則:單張圖片處理時間不能超過3秒;如果偶爾超時,自動留紀錄,下回可回頭檢查設備還是優化參數看看咧。

1. 檢核模型結果怎觀察?

程序跑完後看主控台綜整報表,可直接根據提示窗顏色判斷分類—紅色就是異常(Below Conference)、綠色屬高信心OK(Above Confidence),黃色表示要人工複審(No Result)。倘若預測信心太低,就增補相關缺陷圖片,再訓練強化模型韌性即可。

2. 怎麼追蹤即時優化效果?

當天操作全紀錄匯出成Excel,比對漏檢率及處理平均時間。有某批漏報破10%,代表可能該重整光源組合或加新校正片;若連續三天指標都合格,就是本輪設計達穩定水準,可考慮升級解析度追求更細膩捕捉能力了。

避開常見NG情況提升視覺辨識正確率

根據有些產業專家的經驗,想把大型產線的月維運費壓在新台幣3萬元以內,其實有點門道。特別是你如果全站配20個工作位,那就要特別參考像「單一工站維運成本不能超過整體全自動化費用的3%」這類西方做法喔。這原則主要讓我們能有效率地分配預算,同時又把系統效益拉到不錯的高度,所以不少業內的人會默默拿來當基本指標。不過老實說,等真的實施起來啊,大家多半會祭出一系列進階優化手段,比方說很靈活地避開高風險NG場景、提升視覺辨識穩定度 - 現場實操就是這樣沒錯。

🔗【數據擴充+異常監控】:很多人都知道,把各種小型多樣化資料集(舉例來說,最少得囊括10種工藝,每種100筆樣本)結合即時異常監控,對應到產線就有機會靠近實際生產情況啦。在執行層面,你可能先採用分批交叉標註、逐步加設自動異常通報模組。說到底關鍵就是,必須確保來源資料能持續更新,再搭配高頻率監測流程,好讓模型碰上外界狀況劇變時,也還保有8成以上的應變能力。

🔗【光源動態調節+灰階均值校正】:照明條件其實變數滿大的,用上光源動態調節裝置,再把週期性的灰階卡自動校正連結起來,就真能減少光影波動造成判斷誤差。一般會先啟用追蹤光源亮度那套設定,一旦環境轉換馬上即時補償;然後每次換班前再自動拍灰階卡、去修正鏡頭底下感光參數。結果常看到色階處理準度直接跳級升等。

🔗【多模型輪詢+信心閾值篩選】:簡單講,把像YOLO、ResNet這些不同演算法通通拉進來平行運算,同一批圖反覆比對後再看誰分數最高,再給信心水準達標且一致才錄取標註答案。我認為它強大之處在於能藉由系統自己設閾值,所以識別準確度蠻有感地往上推,而且也能順勢省掉不少人工複審的時間與精力。

其實啊,如果熟悉上述這幾招組合技,就可以一邊顧到經濟性、一邊抵禦像「樣本不足」、「外在環境亂流」、「軟硬體干擾」等超級麻煩的NG問題;自然也可以讓自動化視覺檢查門檻穩步拔高,好吧,大致分享到這裡啦。

🔗【數據擴充+異常監控】:很多人都知道,把各種小型多樣化資料集(舉例來說,最少得囊括10種工藝,每種100筆樣本)結合即時異常監控,對應到產線就有機會靠近實際生產情況啦。在執行層面,你可能先採用分批交叉標註、逐步加設自動異常通報模組。說到底關鍵就是,必須確保來源資料能持續更新,再搭配高頻率監測流程,好讓模型碰上外界狀況劇變時,也還保有8成以上的應變能力。

🔗【光源動態調節+灰階均值校正】:照明條件其實變數滿大的,用上光源動態調節裝置,再把週期性的灰階卡自動校正連結起來,就真能減少光影波動造成判斷誤差。一般會先啟用追蹤光源亮度那套設定,一旦環境轉換馬上即時補償;然後每次換班前再自動拍灰階卡、去修正鏡頭底下感光參數。結果常看到色階處理準度直接跳級升等。

🔗【多模型輪詢+信心閾值篩選】:簡單講,把像YOLO、ResNet這些不同演算法通通拉進來平行運算,同一批圖反覆比對後再看誰分數最高,再給信心水準達標且一致才錄取標註答案。我認為它強大之處在於能藉由系統自己設閾值,所以識別準確度蠻有感地往上推,而且也能順勢省掉不少人工複審的時間與精力。

其實啊,如果熟悉上述這幾招組合技,就可以一邊顧到經濟性、一邊抵禦像「樣本不足」、「外在環境亂流」、「軟硬體干擾」等超級麻煩的NG問題;自然也可以讓自動化視覺檢查門檻穩步拔高,好吧,大致分享到這裡啦。

面對影像誤判如何降低產品風險

說到產線現場,其實經驗告訴我,有兩種情況最容易拉響「危險警報」 - 數據回傳延遲還有模型升級卡住。欸,這真的是業界通病啦。例如2023年,東南亞有一家消費電子廠深夜時出包:夜班發生噪點異常,卻沒人及時把消息上報,結果24小時內出貨的面板居然有1.2%都帶著瑕疵,被退貨損失直接跳到新台幣500萬元這麼高。你看,很誇張吧?

接下來,如果突如其來冒出新的NG影像類型,但團隊三天之內都沒能熱更新模型,還誤判工件、讓瑕疵品混進下一個工作站……整個下游檢測部門馬上壓力山大,不只要重查所有流程,重工費用還硬生生翻倍。不敢想會多累。

那怎麼預防?大多數製造廠商會搞雙重預警體系。首先,只要關鍵指標(例如異常率超過0.5%)就立刻打出紅色警示燈;再來,就是在五分鐘內火速開啟人工覆核介面,由資深夥伴直接線上參與調查、一起做決策。我自己覺得這種「分層緊急介入」機制,在技術保護網還沒完全蓋好前,可以很有效阻斷批次性損失蔓延 - 不然等全面自動化成熟,也不知道要多久呢。

接下來,如果突如其來冒出新的NG影像類型,但團隊三天之內都沒能熱更新模型,還誤判工件、讓瑕疵品混進下一個工作站……整個下游檢測部門馬上壓力山大,不只要重查所有流程,重工費用還硬生生翻倍。不敢想會多累。

那怎麼預防?大多數製造廠商會搞雙重預警體系。首先,只要關鍵指標(例如異常率超過0.5%)就立刻打出紅色警示燈;再來,就是在五分鐘內火速開啟人工覆核介面,由資深夥伴直接線上參與調查、一起做決策。我自己覺得這種「分層緊急介入」機制,在技術保護網還沒完全蓋好前,可以很有效阻斷批次性損失蔓延 - 不然等全面自動化成熟,也不知道要多久呢。

常問:AI與人工檢測哪種穩定又好維護?

老實說,最近真的滿常被產線主管問到一個問題:「AI質檢如果失誤或反應慢,是不是只要花15分鐘,人工就可以補回來?」這個想法看起來挺吸引人,不過只能說,在特殊、單一爆發的情境下,勉強能湊合啦。但要是遇上那種很常見、輪班時會一直發生的狀況,靠人力短時間處理根本無法百分之百取代自動系統帶來的效率。像2023年東南亞消費電子廠那一樁,瑕疵率一口氣飆升了1.2%,24小時內就損失500萬元 - 即使馬上動員所有人在現場逐件查驗,但因為生產批量太大又加上訊息傳遞難以完全即時,所以最後還是有些問題產品被流出了。我自己的經驗給出這兩點建議:第一步,要讓AI先當快篩,只要異常比例超過0.5%就自動跳警報,同步用「雲端多模態」協作方式通知不同班次同事;第二步,一旦偵測到首例全新類型異常,就設立專屬通報機制,再由老手分配給指定負責人去做詳細一對一檢查。同時靈活安排組別輪替,以及建立簡單小組任務記錄,其實不僅能顧及產品沒漏掉,也比較能避免現場夥伴疲於奔命。不知你怎麼看?但整體說起來,只要雙軌並行,工廠環境面對各種臨時狀況的彈性會提升,而AI那邊穩定性也更有保障。