今天要來聊聊 AWS。嗯,我知道,一聽到 AWS (Amazon Web Services),很多做行銷或 SEO 的朋友可能就眉頭一皺,覺得「啊,那是工程師的東西,太難了」。老實說,我以前也這麼覺得。我常常看到很多技術型 SEO 的高手,會自己寫爬蟲啊、做實體配對、主題分群什麼的,但真的很少看到有人分享他們是怎麼用 AWS 來搞這些事的。

我自己因為工作的關係,有機會玩到 AWS 很多服務,就發現...欸,不對啊,這裡面很多工具對我們 SEO 來說根本是寶藏,只是被它那個充滿技術味的名稱給耽誤了。說真的,很多時候,只要用對工具,你甚至可以省下一大筆買第三方軟體的錢。所以,我想用一個比較...嗯,說人話的方式,分享一下我們做 SEO 的,到底可以怎麼「利用」AWS 這頭巨獸。當然啦,我也還在學,這裡只是拋磚引玉,分享一些我覺得超實用的點。

一句話結論

簡單講,把 AWS 當成一個超強大的工具箱,裡面有很多現成的工具可以幫你自動化監控網站、提升速度、甚至玩點 AI 應用,讓你不用再凡事都拜託工程師,或是花大錢買一堆外部服務。

網站一改版就出包?交給 Lambda 這個超盡責的臨時工

好,第一個要說的,絕對是 AWS Lambda。這東西,我自己是覺得,根本是為了防止網站改版悲劇而生的。

你有沒有遇過那種...很扯的狀況?比如說,工程師只是改了個小地方,結果全站的 canonical 標籤突然全部指向首頁?或是更慘的,多語系網站的標題,一夕之間全部變回英文版?我跟你說,這些我都遇過。這種鳥事通常不會寫在工程師的測試腳本裡,所以每次都等到流量掉了、排名消失了才發現,那時候真的...欲哭無淚。

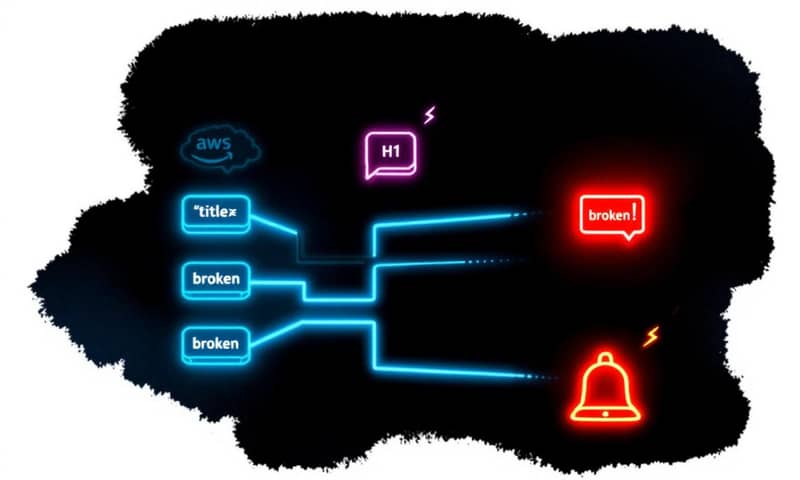

Lambda 就是來解決這個問題的。你可以把它想像成一個「只在需要時才出現」的超迷你機器人或臨時工。你可以寫一個很簡單的 Python 腳本,告訴它:「欸,你每天半夜三點,去幫我檢查一下我們最重要的那幾百個頁面,title、H1、canonical 是不是都還在,而且內容是我要的那個樣子。」

如果檢查發現不對勁,比如說 title 少了個字,或是 canonical 又亂指,它就會立刻觸發警報,用 Email (透過 Amazon SNS) 通知你。整個過程全自動,你早上進公司,就能看到報告,而不是等著看 Google Search Console 的紅色警戒。

這跟用 Screaming Frog 排程去爬,或是用 ContentKing 這類服務有什麼不一樣?最大的差別是「精準」。我以前用過那些工具,但它們太敏感了,有時候只是網頁上換了一張圖、改了個價格,它就叫個不停,搞到後來你根本就麻痺了,狼來了都不知道。但用 Lambda 跑自己寫的腳本,你可以百分之百定義「什麼才算是災難」,只有你最在乎的東西被動到,它才會叫。零誤報,這點真的很重要。

採購/預算思路:Lambda vs. EC2 到底怎麼選?

說到這個,一定會有人問,啊我用 Amazon EC2 開一台虛擬主機,讓它 24 小時跑爬蟲不行嗎?當然可以,但這就像你只是要去巷口買個醬油,卻開了一台大卡車出門。

EC2 是一台「永遠開著」的伺服器,不管你有沒有在用它,它都在那邊燒錢。Lambda 則是「serverless」無伺服器架構,你不用管主機,它只有在被觸發執行任務的那幾秒鐘或幾分鐘內才計費,任務一結束,它就消失了,完全不佔資源。對於「監控」這種偶發性、短時間的任務來說,用 Lambda 的成本可能只有 EC2 的零頭。

為了讓你更好懂,我弄了個簡單的比較表:

| 比較項目 | AWS Lambda | Amazon EC2 |

|---|---|---|

| 比喻來說 | 像叫 Uber 或計程車,有需要才叫車,按里程計費。 | 像自己買一台車或租一整天,不管開不開,保險、停車費、折舊都在算。 |

| 計費方式 | 執行次數 + 執行時間(精確到毫秒)。沒跑就幾乎不花錢。 | 開機時間(通常以小時或秒計)。關機才不計費。 |

| 適合的 SEO 任務 | 定時檢查 on-page 元素、監控 robots.txt 變動、小規模爬取、API 串接... 這種跑一下就結束的。 | 需要長時間運算的工作,例如用 Screaming Frog 爬幾十萬頁的大型網站、跑複雜的數據分析模型。 |

| 管理難度 | 比較低。你只要專心寫好你的程式碼(那個腳本),不用管主機、作業系統、更新。 | 比較高。你要自己選機型、裝軟體、做系統更新、管安全設定,就像在養一台真的電腦。 |

| 一句話建議 | 想做自動化監控或觸發式任務,選這個,便宜又大碗。 | 有需要長時間掛著跑的重度運算需求,才考慮這個。 |

網站速度優化?CloudFront 這個加速器不能不用

再來,講到 SEO,就不能不提網站速度,尤其是 Core Web Vitals。這部分,Amazon CloudFront 就是你的神兵利器。

CloudFront 簡單講就是 CDN (Content Delivery Network,內容傳遞網路)。這是什麼概念呢?假設你的網站主機放在美國維吉尼亞,但你的使用者大部分在台灣。那每次台灣的使用者打開你的網站,瀏覽器就要飄洋過海去跟美國的主機要資料,一來一回,光是物理距離就夠慢的了。

CDN 就是在全球各地,比如日本、新加坡、歐洲...建立很多「快取節點」(cache server)。當台灣使用者第一次來你網站後,CloudFront 就會把你的網站內容,比如圖片、CSS、JS 檔案,複製一份存放在離台灣最近的日本或新加坡節點。下次再有台灣使用者來,瀏覽器就不用跑去美國了,直接從日本拿資料就好,速度當然快上好幾倍。這對 LCP (最大內容繪製) 的改善是立即性的。

說到這個,我就要岔開提一下。很多公司在用 AWS 時,為了方便或省事,註冊時區域 (Region) 就隨便選,常常選到預設的美國東岸。但如果你是做台灣或亞洲市場的生意,拜託,至少把你的主要服務部署在東京 (ap-northeast-1) 或新加坡 (ap-southeast-1) 這種離你用戶近的區域。這點在 AWS 官方的全球基礎設施說明頁上都寫得很清楚。CDN 是加速「內容分發」,但如果你的主機本身就離很遠,那個「第一口氣」(TTFB, Time to First Byte) 就會慢掉,後面再怎麼加速效果都有限。主機區域選對,再配上 CloudFront,才是完整的速度優化。

CloudFront 還有很多進階玩法,比如它可以偵測使用者的裝置(手機還是電腦)、地理位置(國家、城市),然後傳送不同的內容給他。這比用 cookie 或 IP 判斷來做動態內容要可靠得多。

S3:不只是雲端硬碟,更是 SEO 的瑞士刀

很多人以為 Amazon S3 就只是個存檔案的雲端硬碟,像 Google Drive 或 Dropbox。對,也不對。對 SEO 來說,它遠不止如此。

我自己覺得 S3 有幾個超實用的地方:

- 存放 sitemap.xml 跟 robots.txt:這兩個檔案雖然小,但很重要。把它們放在 S3 上,你可以拿到一個公開的 URL,直接填到 GSC 後台。好處是?以後你要修改 robots.txt,不用再拜託工程師重新部署上線,你自己登入 AWS 控制台,把新檔案覆蓋上去,秒速搞定。自主權超高。

- 當圖床:網站上大量的圖片其實很吃主機流量和空間。把所有圖片都上傳到 S3,然後在網頁裡用 S3 的 URL 來讀取,可以大幅降低你主伺服器的負擔。而且 S3 的費用...說真的,便宜到你會笑。再搭配上面說的 CloudFront,圖片載入速度也是飛快。

- 存放靜態檔案:有時候你可能只是想做一個簡單的 HTML 活動頁,只有幾張圖跟文字,根本不需要動到複雜的後端資料庫。你可以直接把整個 HTML 檔案丟到 S3 上,設定成公開讀取,它就變成一個可以瀏覽的網頁了。超級省事。

想玩 AI?從 SageMaker 到 Bedrock 這些是進階武器

好,接下來這幾個就比較...嗯,比較潮一點,也比較進階。說真的,這些工具如果能用好,絕對可以把你的 SEO 工作帶到另一個層次,但學習曲線也比較陡峭。

- Amazon SageMaker:這東西主要是用來「訓練機器學習模型」的。舉個 SEO 的例子,假設你從 Google Search Console 下載了幾十萬筆關鍵字,你想把它們分類成「品牌字」、「產品字」、「資訊字」、「導航字」...靠人工一個個標籤,可能會標到天荒地老。你可以先手動標個幾百、幾千個當作「範本」,然後把這些範本丟給 SageMaker,讓它去「學習」你的分類邏輯。學會之後,再把剩下幾十萬筆丟給它,它就能在幾分鐘內幫你全部分類好。超猛。

- Amazon Comprehend:這是做「自然語言處理」(NLP) 的服務。你可以丟一篇文章給它,它會幫你抓出裡面的「實體」(Entities),比如人名、地名、品牌、產品。然後它還會告訴你這篇文章跟每個實體之間的「顯著性分數」(salience score)。這有什麼用?有時候你寫了一篇關於「蘋果」的文章,但一直排不上去,用 Comprehend 一分析才發現,你文章裡提到太多「富士」、「甜度」、「果園」等字眼,導致 Google 可能認為你的內容其實更偏向在講「富士蘋果」這個更精確的實體,而不是在講「蘋果」這個水果大類。這可以幫你檢查內容有沒有失焦。

- Amazon Bedrock / Q / PartyRock:這三個就是現在最紅的生成式 AI 相關服務了。Bedrock 讓你可以串接很多家的大型語言模型(LLM)來建立自己的 AI 應用;Amazon Q 則比較偏向企業內部使用的 AI 助理;PartyRock 則是一個免費、好玩的平台,讓你不用寫程式碼,用拖拉的方式就能做出自己的 GenAI App。對 SEO 來說,你可以用這些工具來做什麼?嗯...比如說,建立一個「標題生成器」,你給它產品名和幾個關鍵字,它就幫你生成 10 個不同風格的 SEO 標題。或是做一個「內容大綱產生器」,都很有想像空間。

老實說,AWS 的服務真的多到爆炸,什麼 Lightsail 可以用來架站、CloudWatch 可以做監控儀表板...等等。但今天講的這幾個,Lambda、CloudFront、S3,還有那些 AI 工具,是我自己覺得跟 SEO 最直接相關,而且導入後效果最明顯的。

重點真的不是要你變成一個多厲害的雲端架構師。而是讓你知道,原來有這些武器可以用。下次你再遇到網站出包、速度太慢,或是需要處理大量重複性工作時,你的腦中除了「找工程師」或「買軟體」之外,還可以多一個選項:「欸...我們是不是可以試試看用 AWS 的某個服務來解決這個問題?」

光是能提出這樣的問題,你在團隊裡的價值,就完全不一樣了。

換你聊聊

除了上面提到的這些,你們公司或你自己,還用過 AWS 的什麼服務來幫助 SEO 工作嗎?或者,有沒有在導入哪個服務時卡關、覺得超難用的經驗?在下面留言分享一下吧,搞不好大家可以一起找答案!