最近、ずっと考えてて。SEOのこと。僕が管理してるいくつかのサイト、まあ、そこそこのトラフィックはあるんだけど、なんていうか… 頭打ち感? があったんだよね。もうこれ以上は伸びないんじゃないか、みたいな。色々やってるつもりなのに、景色が変わらない感じ。

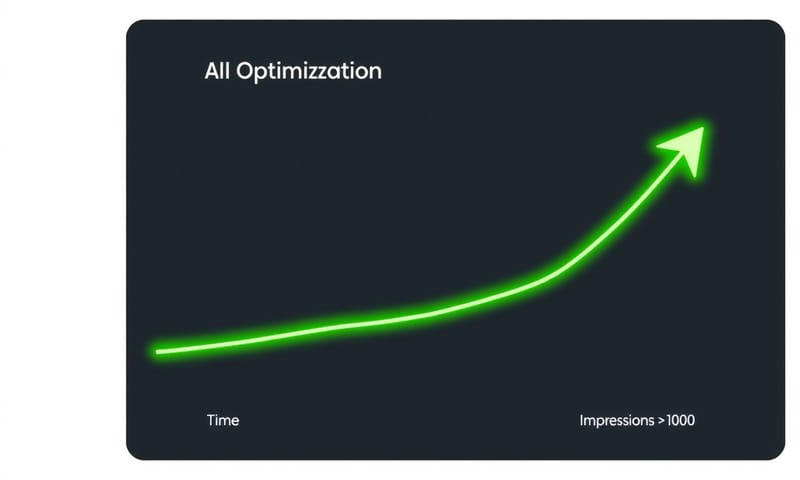

でも、ある一つのことを試したら、本当に、ええと…世界が変わった。大げさじゃなく。特に力を入れた記事群の検索表示回数が、気づいたら4倍くらいになってた。正直、目を疑ったよ。

しかも、これ、僕だからできたとか、何か特別なスキルが必要とか、そういう話じゃ全くないんだ。むしろ、僕自身のSEOスキルを遥かに超えた結果が出ちゃった、というのが正しい。うん。今日はそのことについて、ちょっと整理しながら話してみようと思う。

で、結局何をやったのか?

やったことは、すごくシンプル。要するに、GoogleのAIが読みやすいようにコンテンツを整えること。それを、人力じゃなくて、AIにやらせた。ただそれだけ。

最近のGoogleって、もうキーワードの数とか見てないじゃん? 検索してる人が「何を知りたいのか」っていう意図を、AIが一生懸命理解しようとしてる。だから、こっちもそれに合わせて、記事の構造とか、トピックの関連性とかを、もっと分かりやすくしてあげる必要があるんだよね。

でも、これが… めちゃくちゃ面倒くさい。正直、やってられない。そこで、今一番賢いって言われてるAI、Claude… そう、ソースの記事はClaude 3.7って書いてたけど、今だと最新のClaude 3.5 Sonnetかな。うん、そっちのほうが速くて安いし。とにかくそいつと、Make.comっていう自動化ツールを組み合わせて、その面倒な作業を全部任せてみたんだ。

きっかけは、海外のSEO系の人が公開してたプロンプト。それを日本語向けにちょっと調整して、試してみたのが始まり。

古いサイトで試した2つの実験

理論はわかっても、実際に効果があるかどうかが一番大事だから。それで、もう何年も放置してた古いサイトが2つあったんで、思い切って実験台にしてみたんだ。

一つ目のサイトは、かなり大胆な方法で。もうほとんど誰も読んでないような古い記事を、AIに「この記事、今の読者向けに完全に書き直して」って丸投げした。内容の骨子は残しつつ、構成から言い回しまで全部作り直させた感じ。まあ、もともとゼロみたいな記事だったから、失うものは何もないしね。博打みたいなもんだった。

もう一つのサイトは、もうちょっと繊細なアプローチ。こっちは記事数は150くらいあって、そこそこ内容はあったんだけど、致命的な問題があって。記事同士が全然繋がってなかったんだ。内部リンクがぐちゃぐちゃで、せっかくのトピッククラスター… つまり、関連する記事群が、Googleから見てバラバラの点にしか見えてなかった。

だから、こっちは「記事の内容はあまり変えずに、関連する記事への内部リンクを適切に追加・整理して」って指示を出した。具体的には、スプレッドシートに関連記事のIDをまとめておいて、自動化ツールに読み込ませて、一件一件処理させていった。これは、正直、人間がやったら気が遠くなる作業だよね。

この二つの実験が、最終的にどういう結果になるかは、まだ完全にはわからない。Googleがサイトを再評価するのに、まあ、数週間から数ヶ月はかかるだろうし。でも、最初の兆候として、冒頭で話した「表示回数400%増」っていう数字が出てきた。これは、希望が持てるよね。

人力SEO vs AI自動化、何が違う?

じゃあ、なんでこんなに差が出たのか。僕が今まで必死にやってた手作業のSEOと、AIに任せたやり方で、具体的に何が違ったのかをまとめてみた。たぶん、ここが一番大事なポイント。

| 比較項目 | 今までの人力SEO | AIを使った自動化SEO |

|---|---|---|

| コスト | 高い。外注したら月数十万とか。自分でやっても、自分の時間が…。 | めちゃくちゃ安い。API代だけだから、記事1本あたり、たぶん10円とかそれくらい。 |

| 時間 | 絶望的にかかる。1記事直すのに数時間。100記事なんて考えたくもない。 | 一瞬。本当に。設定さえ済めば、100記事でも数十分とかで終わるんじゃないかな。 |

| 品質 (構造化) | 担当者のスキル次第。正直、僕のレベルだと完璧な構造化は無理だった。見落としも多いし。 | 人間超え。少なくとも僕よりはるかに上手。網羅的だし、論理的。たまに変な日本語になるけど、そこは後で直せばいい。 |

| 拡張性 | ほぼ無い。サイトが大きくなると破綻する。無理。 | 無限大。記事が何百、何千あっても同じように処理できる。これが一番ヤバい。 |

要するに、AIがやったのは「意味的に関連するコンテンツを、内部リンクで綺麗に繋ぎ合わせ、Googleに『うちはこのテーマの専門家ですよ』とアピールする」っていう、SEOの王道なんだ。でも、その王道を、人間には不可能な規模と精度で実行した。…その結果が、あの数字なんだと思う。

これって、日本語のサイトでも同じように効くの?

そう、ここ。大事なところだよね。海外の事例だからうまくいったんじゃないか、って。正直、僕も最初は半信半疑だった。でも、今はむしろ逆じゃないかと思ってる。

日本語って、ご存知の通り、漢字、ひらがな、カタカナが混在してて、同じ意味でも表現の「揺れ」がすごく大きい。例えば、「AI 活用」と「AIの活用法」と「AIをうまく使う」では、検索する人の意図が微妙に違う。こういうのを人間が全部網羅してコンテンツ作るのって、すごく大変。

でも、今の賢いAIは、こういう言語の背景にあるニュアンスを理解するのが得意なんだ。だから、人間が見落としがちな関連性を拾って、うまく記事同士を繋げてくれる可能性がある。日本のSEO情報サイト、例えば「Web担当者Forum」みたいなところでも、AIとSEOの共存っていうテーマはよく見るようになった。でも、ここまで具体的な自動化のフローと、その結果っていうのは、まだあまり語られてない気がする。

だから、このやり方は、日本語のコンテンツにこそ、大きなインパクトを与えるんじゃないかな。…なんて、今は考えてる。

じゃあ、明日から何をすればいい?

この話を聞いて、「じゃあ自分も」って思うかもしれないけど、いきなり全部やろうとすると、たぶん挫折する。僕もそうだったから。大事なのは、小さく始めること。

まずは、自分のサイトで一番読まれてほしい「核」となる記事を一つ選ぶ。で、その記事と関連する記事を5個くらいピックアップする。その6つの記事の間だけでいいから、手作業でいいので、意味が通じるように内部リンクを繋いでみる。それだけでも、Googleからの見え方は少し変わるはず。

自動化は、その次のステップ。Make.comとかZapierとか、そういうツールと、Claude 3.5 SonnetのAPIを契約して、今回話したような流れを組んでみる。最初は難しいかもしれないけど、一度作ってしまえば、あとは資産になるから。

結局、SEOって、Googleっていう巨大なAIとの対話みたいなもんだと思うんだ。その対話のやり方が、ちょっと変わってきた。僕らは、その新しい言語を学んで、できれば通訳(=AI)を雇う、みたいな段階にいるのかもしれないね。

…と、まあ、今日はそんな感じかな。正直、この結果にはまだ興奮してるし、これからどうなるか、楽しみでもあり、少し怖くもある。うん。

こういう自動化、自分のサイトで試してみたいと思う? それとも、やっぱりコンテンツは一つ一つ手で書きたい派? もしよかったら、あなたの考えも聞かせてほしいな。