いきなり結論から言うと

コアウェブバイタル(Core Web Vitals)を改善したからって、それだけで検索順位が急に上がる、なんてことは、まあ無い。 でも、無視していいわけでもない。Googleは「コンテンツの質が同じくらいなら、体験が良い方を優先するよ」とはっきり言ってるから。 要は、最低限の足切りラインみたいなものかな、と考えてる。

大事なのは、数字を良くすること自体が目的じゃなくて、あくまで「ユーザー体験を良くするため」の一環だってこと。その結果として、SEOにも良い影響があるかもしれない、くらいが健全な向き合い方だと思う。今日はその効果をどうやって測って、見ていけばいいのか、ちょっと頭の中を整理してみる。

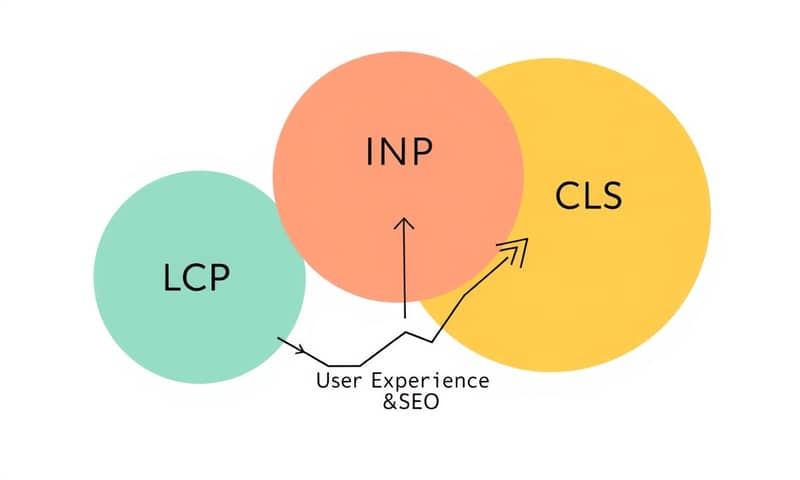

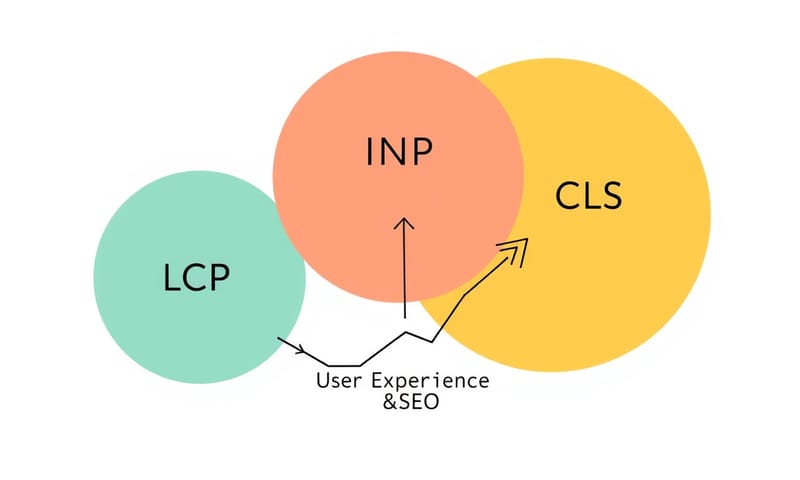

LCP, INP, CLS…結局なにをどう見ればいい?

まず、指標は3つ。LCP、INP、CLS。 2024年3月にFID(First Input Delay)っていうのが無くなって、代わりにINP(Interaction to Next Paint)が入ってきた。 これは結構大きな変更で、クリックとかタップへの反応性全体を見るようになったから、より実態に近い指標になった感じがする。

- LCP (Largest Contentful Paint):ページのメインコンテンツが表示されるまでの時間。これが遅いと、ユーザーは「このサイト、遅いな」って感じる。2.5秒以内が「良好」の目安。

- INP (Interaction to Next Paint):クリックやタップしてから、画面が反応するまでの時間。メニューを開いたり、ボタンを押したりした時の「待たされ感」のこと。200ミリ秒未満が「良好」。

- CLS (Cumulative Layout Shift):ページを読んでる途中で広告や画像が読み込まれて、ガクンとレイアウトがずれる、あれ。あれがどれくらい起きるか、という指標。0.1未満が「良好」。

正直、全部「良好」にするのは大変。だから、まずは「不良」を「要改善」に持っていく、くらいの目標でいいんじゃないかな。

じゃ、どうやって測るの?ツールの選び方

ツールはいろいろあるけど、目的によって使い分けるのが大事。 いつもPageSpeed Insightsのスコアだけ見て一喜一憂してるなら、ちょっと待ってほしい。

| ツール名 | 何がわかる?(個人的な見解) | どう使う? |

|---|---|---|

| Google Search Console | 一番大事。実際のユーザーがどう体験してるか(フィールドデータ)がわかる。 「不良URL」リストは、まずここから見るべき。 | 定期的に「ウェブに関する主な指標」レポートをチェック。どのページグループで問題が起きてるか、全体像を把握する。 |

| PageSpeed Insights | URLを1つ入れるだけで、手軽にラボデータ(シミュレーション環境)とフィールドデータ(過去28日間)の両方を見れる。 | 特定のページを改善したあと、すぐに効果を確認したい時。ただ、ラボデータのスコアはブレるから参考程度に。 |

| Lighthouse (Chrome拡張機能/DevTools) | 開発者向けのガチなやつ。自分のPCで、今まさに表示してるページのパフォーマンスを計測できる。 | 改善作業中に、手元で何度もテストする時。「ここのJavaScriptが原因か?」みたいな仮説検証に使う。 |

| Web Vitals 拡張機能 | ブラウジングしながら、訪れたサイトのCWVを手軽にチェックできる。競合サイトの状況を見るのにも便利。 | 「あのサイト、なんで速いんだろう?」と思った時にサッと確認。普段使いに。 |

基本は、Search Consoleで問題のあるURLグループを特定して、PageSpeed InsightsやLighthouseで個別の原因を探っていく、っていう流れかな。

よくある誤解と、現実的な落としどころ

ここでいくつか、よくある誤解を解いておきたい。

- 「スコアを100点にすれば順位が上がる」という誤解:さっきも言ったけど、そんな単純じゃない。 コンテンツがダメなら、いくら速くても意味がない。あくまで同レベルのコンテンツ同士の比較で、少し有利になる程度。

- 「ラボデータだけ見てればOK」という誤解:Lighthouseのスコアは、あくまで特定の環境でのシミュレーション。 大事なのはSearch Consoleに出る、実際のユーザーのデータ(フィールドデータ)の方。

- 「全部一気に直さないと」という誤解:リソースは有限。まずはトラフィックが多くて、ビジネス上重要なページから手をつけるべき。 例えば、ECサイトならトップページより商品詳細ページやカートページの方が優先度は高いかもしれない。

特に日本のサイトだと、Webフォントの読み込みがLCPに影響しやすい、みたいな特有の問題もある。 英語圏の一般的なアドバイスを鵜呑みにするんじゃなくて、web.devみたいなGoogleの公式情報と、日本のサーバー環境やユーザーのネットワーク状況を考慮して、バランスを取る必要がある。

で、結局SEO効果ってどう測るの?

これが一番難しい問題。正直、「これをやれば、こう測れます」みたいな銀の弾丸はない。なぜなら、順位変動の要因はコアウェブバイタル以外にも山ほどあるから。

だから、直接的な因果関係を証明しようとするより、相関関係を見るのが現実的かなと思う。

- 定点観測する:Search Consoleで「不良URL」の数がどう変化したか、週次や月次で記録する。

- 前後比較する:大きな改善(例えば、画像の全面的なWebP化とか)を実施したタイミングの前後で、対象ページの平均掲載順位やクリック数、直帰率(Google Analyticsで見る)に変化があったかを見る。

- 仮説を立てる:「INPを改善したから、CTAボタンのクリック率が上がったんじゃないか?」みたいな仮説を立てて、A/Bテストができれば理想。

これも、劇的な変化が見えることは稀。でも、長期的に見て、サイトの健全性が上がっていくのを確認することはできる。地道だけど、それが一番確実な方法なんだと思う。

まとめ:焦らず、でも着実に

コアウェブバイタルの対応は、派手なSEO施策じゃない。むしろ、サイトの「基礎体力」をつけるための地味なトレーニングみたいなもの。すぐに結果は出ないけど、やっておかないと、いざという時に競合に差をつけられる。

完璧を目指さず、まずはSearch Consoleで「不良」と判定されたページをなくすこと。 そこから始めてみるのが、一番いいんじゃないかな。結局、ユーザーが快適に使えるサイトを作ることが、遠回りのようで一番の近道なんだと、最近よく思う。

あなたのサイトで一番の課題になってるのは、LCP、INP、CLSのどれですか? もしよかったら、コメントで教えてくれると嬉しいです。